Rag Checker

RAG Checker 페이지에서는 질문-응답 데이터를 기반으로 문서를 업로드하고, 응답이 문서(Context)에 근거했는지를 자동 평가할 수 있습니다.

이 기능은 아래 두 모델을 활용합니다:

- Decomposition 모델을 통해 응답 내용을 Claim 단위로 분해합니다.

- Entailment 모델을 활용해 각 Claim이 문서에 기반하는지를 판별합니다.

이 기능은 RAG 정확도 분석, hallucination 검출, 모델 간 비교 평가에 유용하게 활용됩니다.

프로젝트 생성

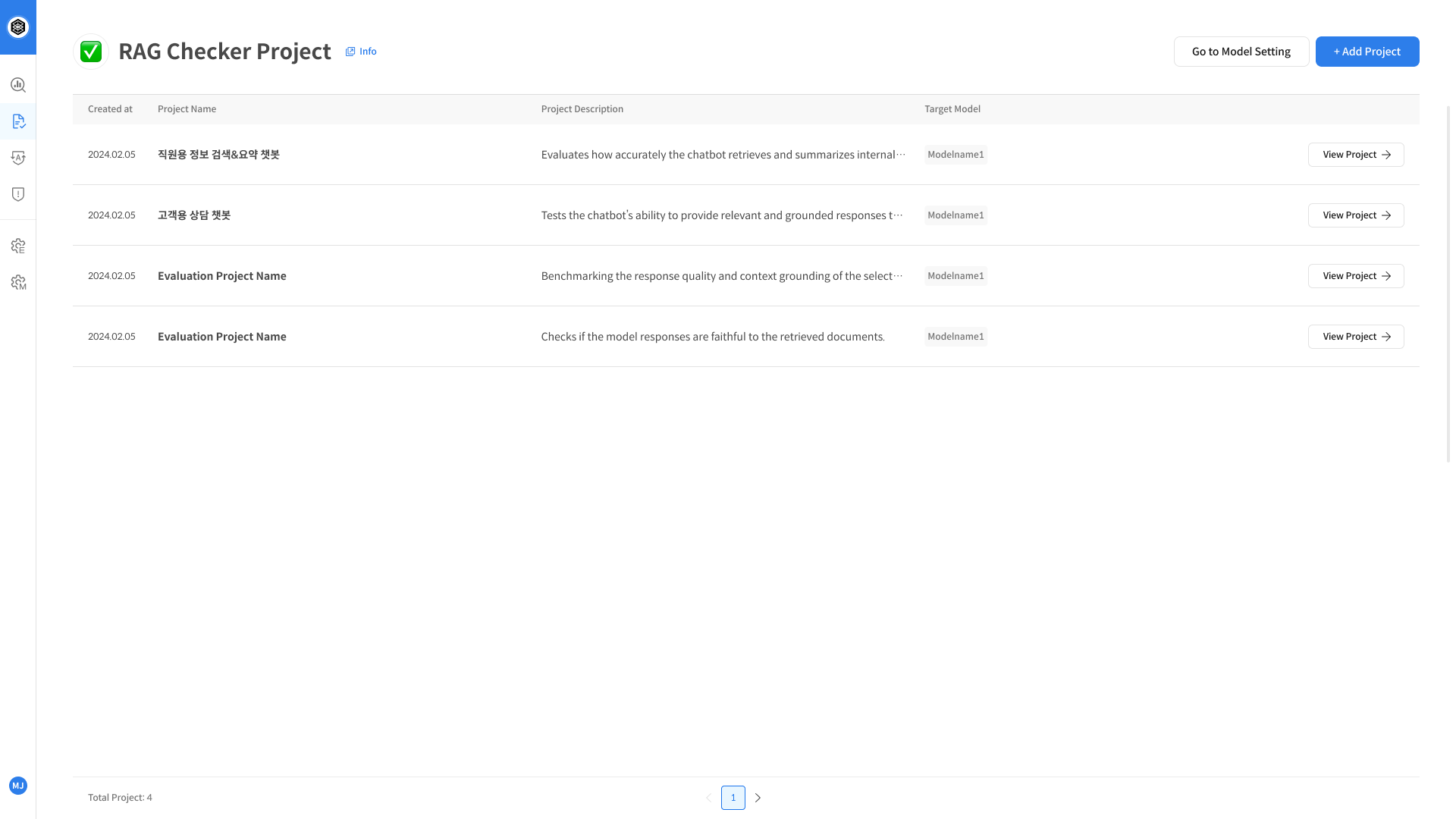

① RAG Checker Project 생성

좌측 네비게이션에서 [RAG Checker] 항목을 클릭하면 평가 화면으로 이동합니다.

기존 프로젝트 목록이 나타나며, 원하는 프로젝트를 선택해 상세 페이지로 들어갈 수 있습니다.

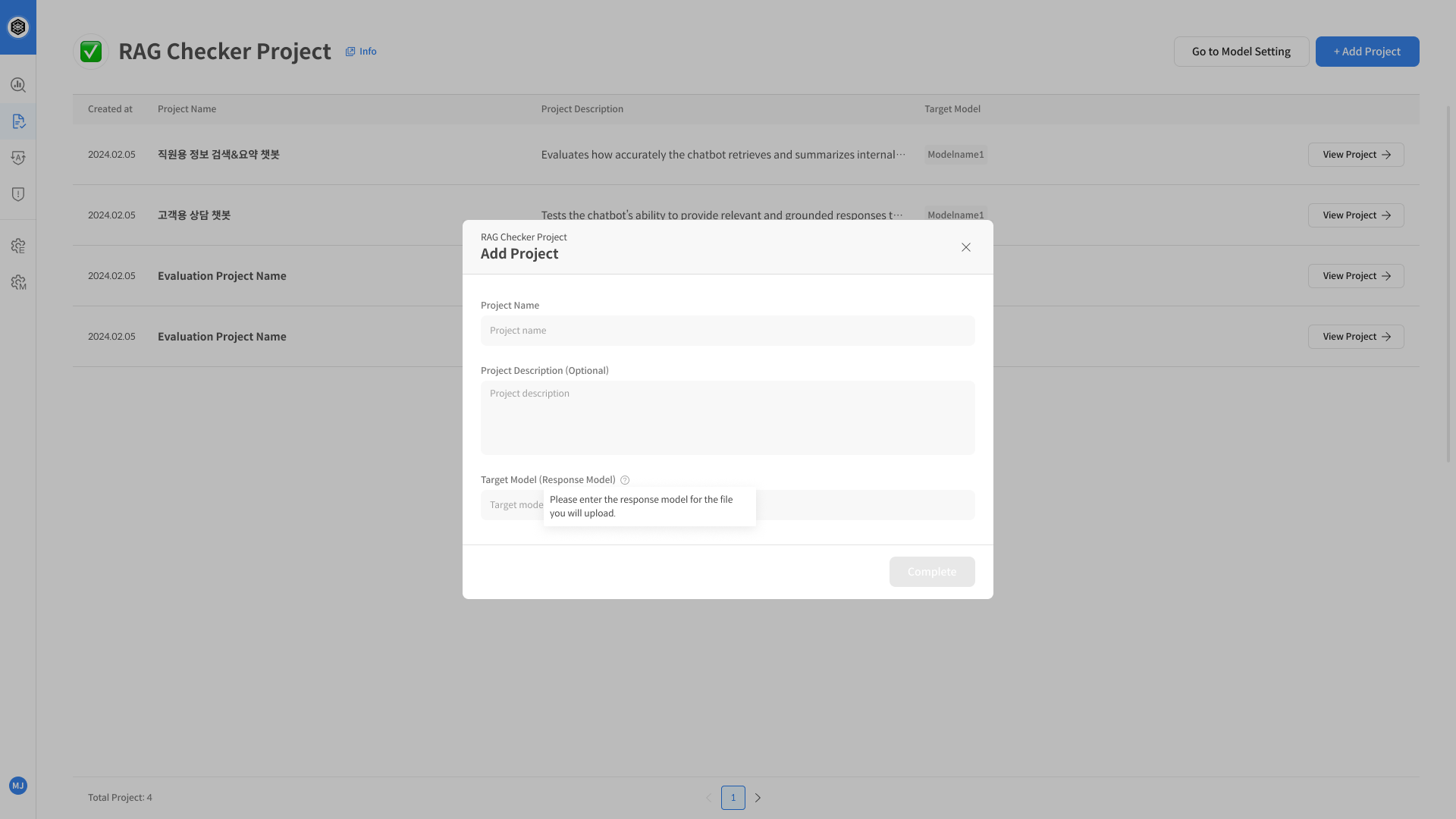

새로운 프로젝트를 만들려면, 화면 우측에 있는 RAG Checker 아이콘을 클릭한 뒤 + Add Project 버튼을 선택합니다.

프로젝트 생성 페이지에서는 프로젝트명, 설명, 그리고 LLM 응답 모델인 타겟 모델명을 입력합니다.

이후 [Create] 버튼을 클릭해 프로젝트를 생성합니다.

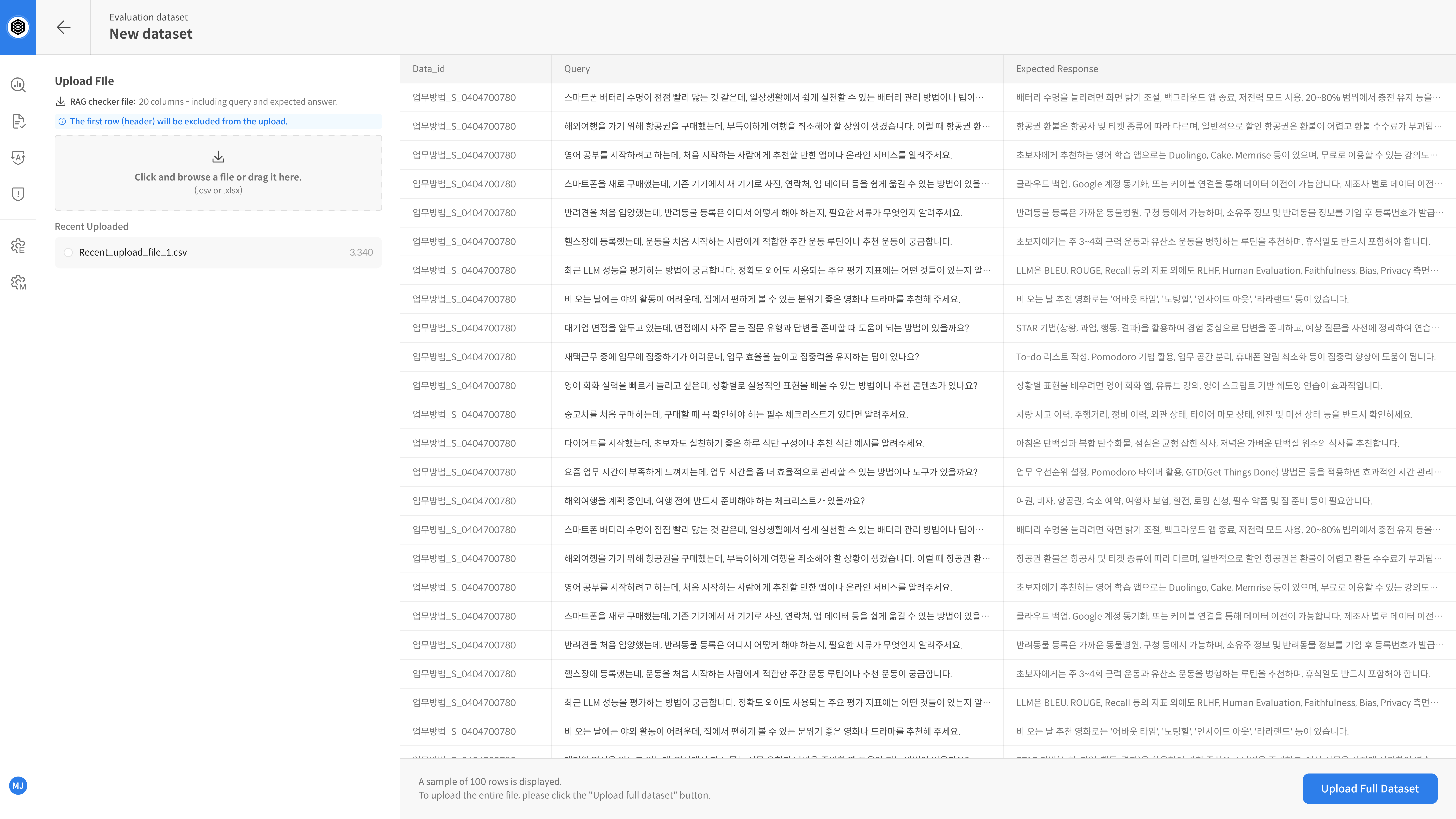

New Dataset

Step 2. 평가 데이터셋 문서 업로드

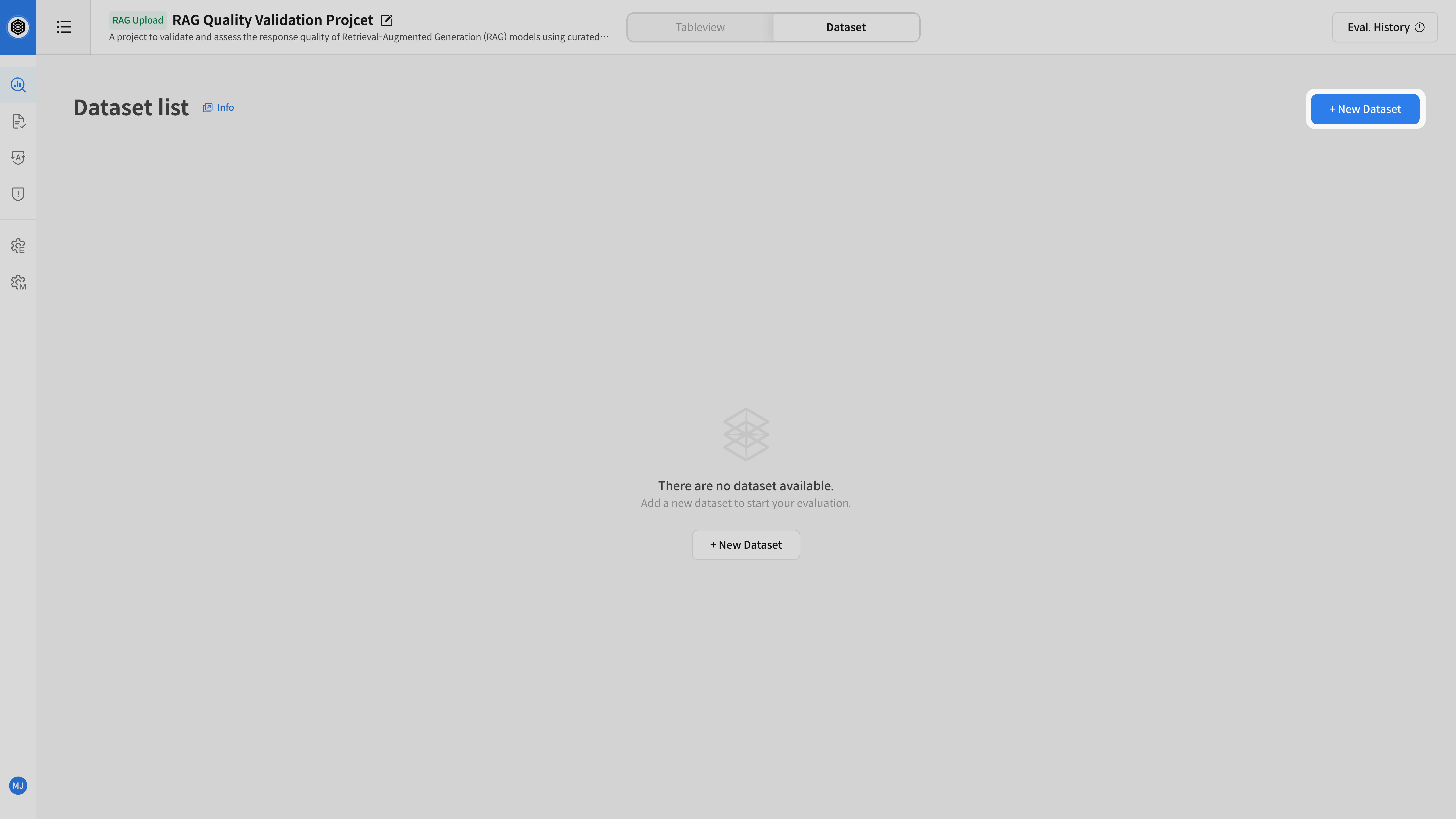

② 데이터셋 생성 화면 진입

평가를 진행할 프로젝트를 클릭한 후, 상단의 [Dataset] 탭으로 이동 한 뒤,

우측 상단의 [New Dataset] 버튼을 클릭하여 데이터셋 생성을 시작합니다.

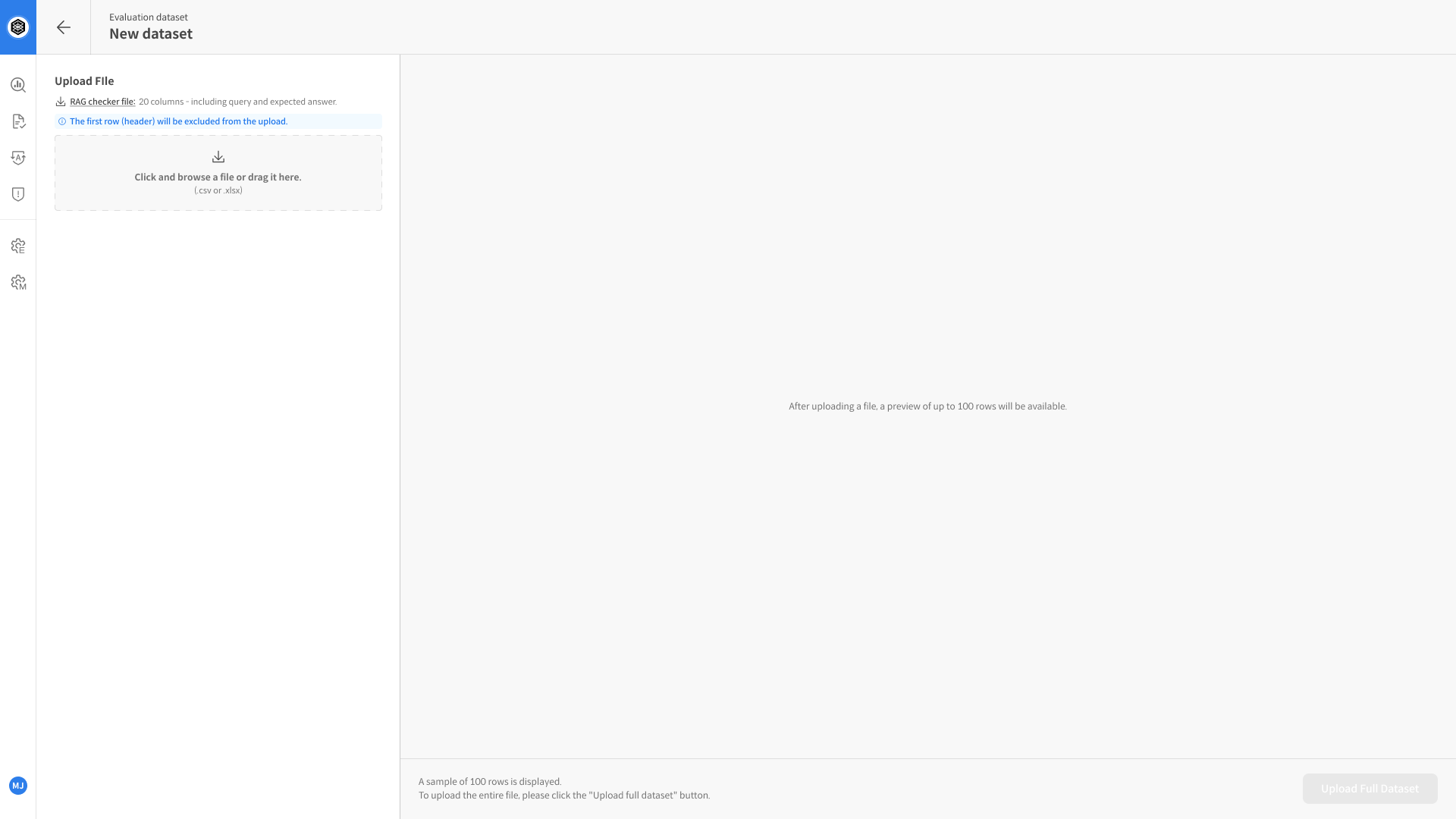

③ 문서 업로드

Upload File 영역에 평가용 문서를 업로드합니다.

형식을 모르겠다면 샘플 문서를 다운받아 내용을 채워주세요.

- 지원 형식:

.csv,.xlsx - 필수 컬럼:

queryexpected_responsetarget_responseretrieved_context1

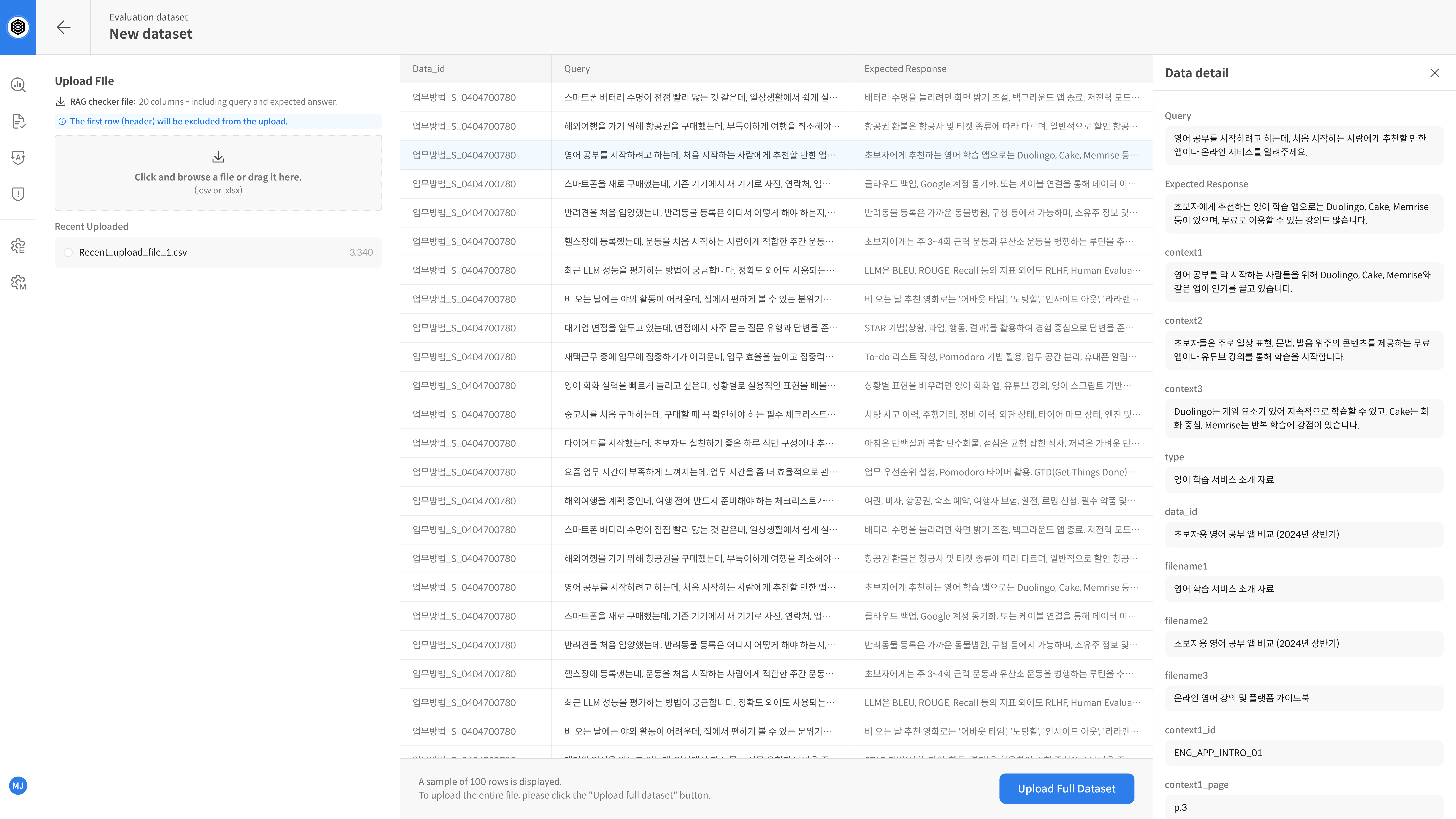

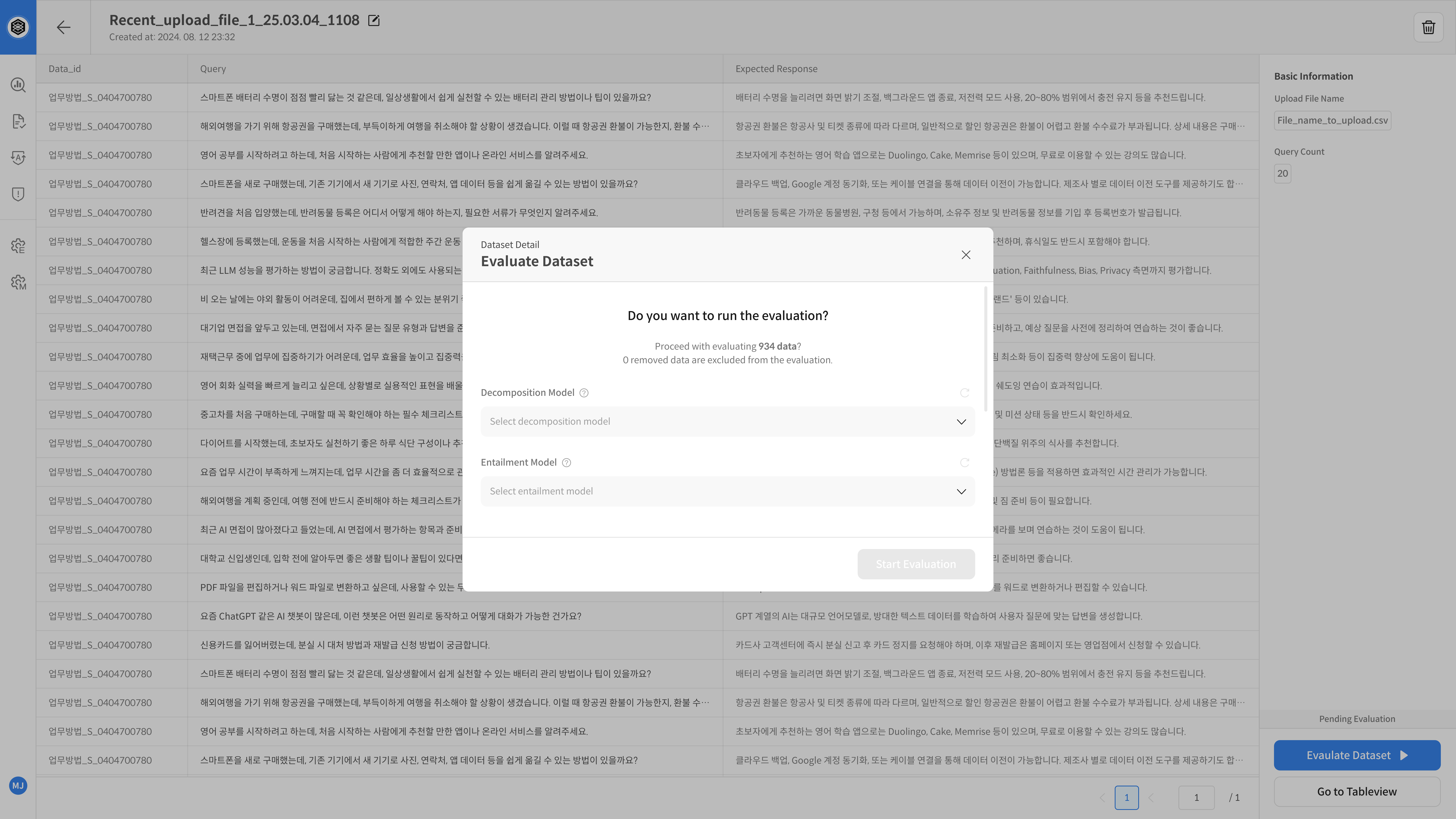

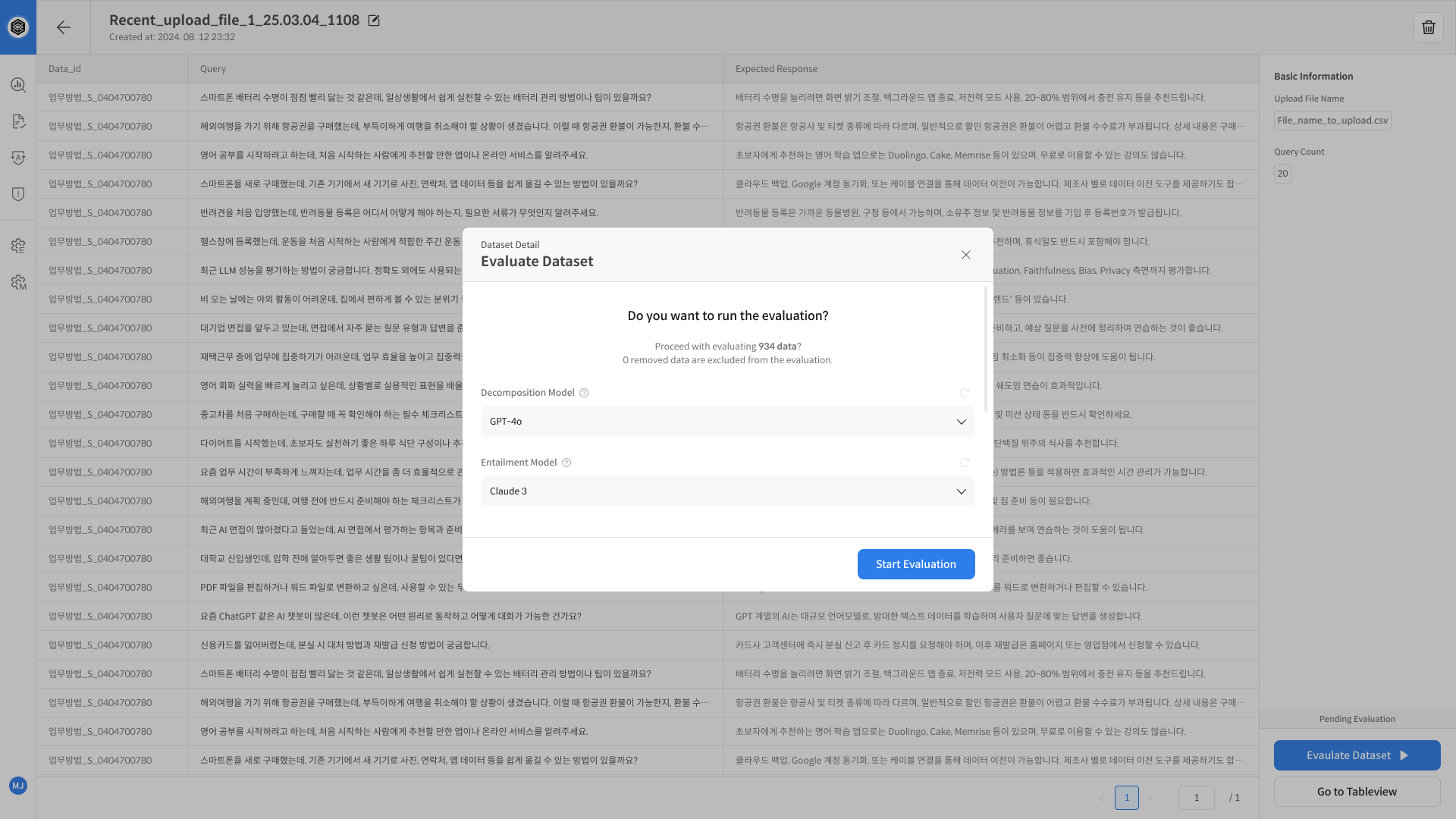

Dataset Detail & Evaluation

④ 샘플 문서 확인

파일 업로드가 완료되면, 최대 100건의 샘플 데이터가 자동으로 미리보기 형태로 표시됩니다.

⚠️ 데이터 수정 및 삭제가 필요한 경우, 파일을 수정한 후 다시 업로드해야 합니다.

업로드 후 샘플로 최대 100개의 데이터 미리보기가 제공됩니다.

각 문서는 Data Detail 화면에서 상세 내용을 확인할 수 있습니다.

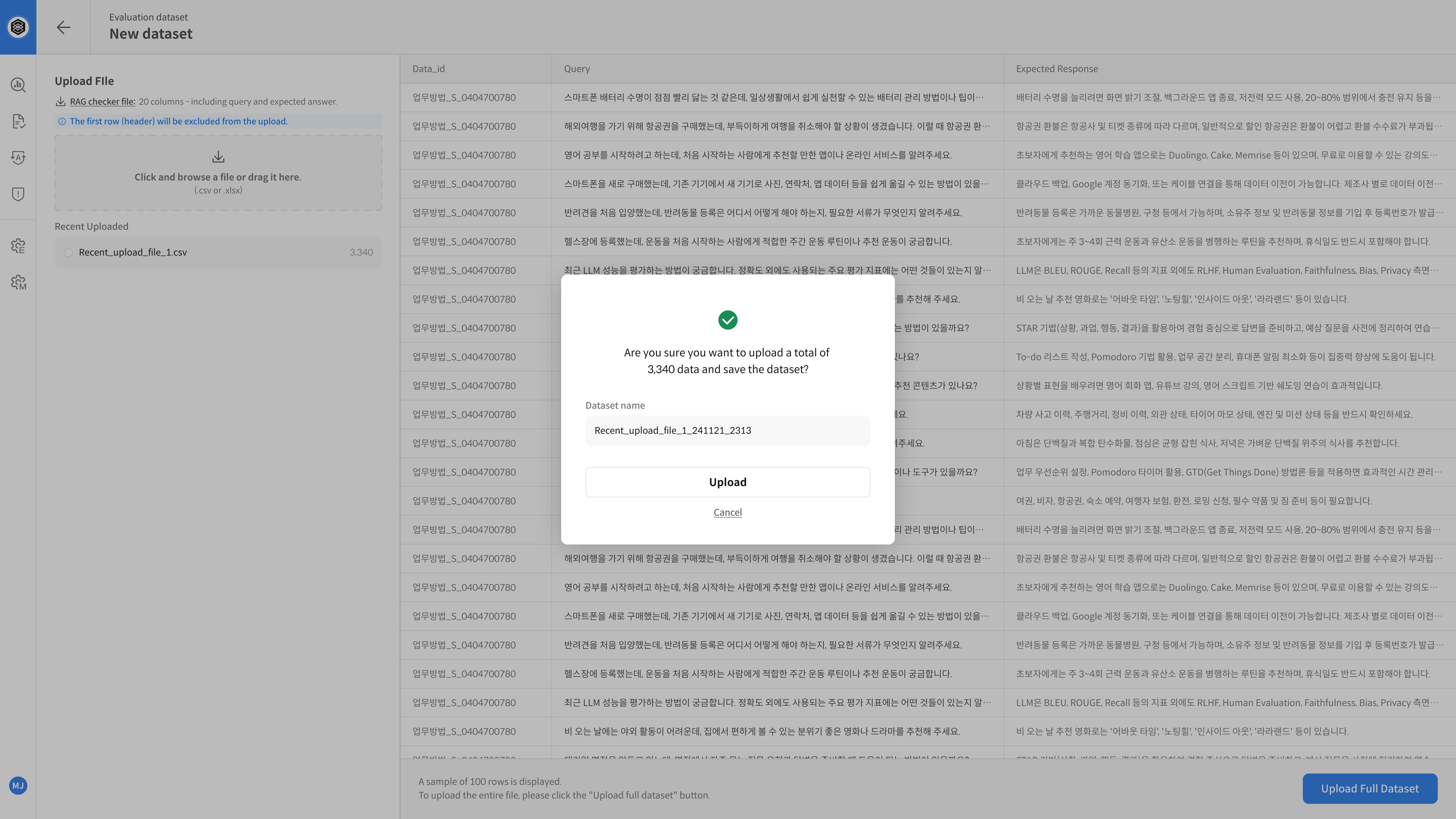

⑤ 데이터셋 저장

샘플 검수 후, 데이터셋 이름을 입력하고 저장합니다. 데이터셋 저장이 완료되면, 해당 프로젝트 내에서 평가 대상으로 바로 사용할 수 있습니다

우측 하단 [Upload Full Dataset] 버튼 클릭

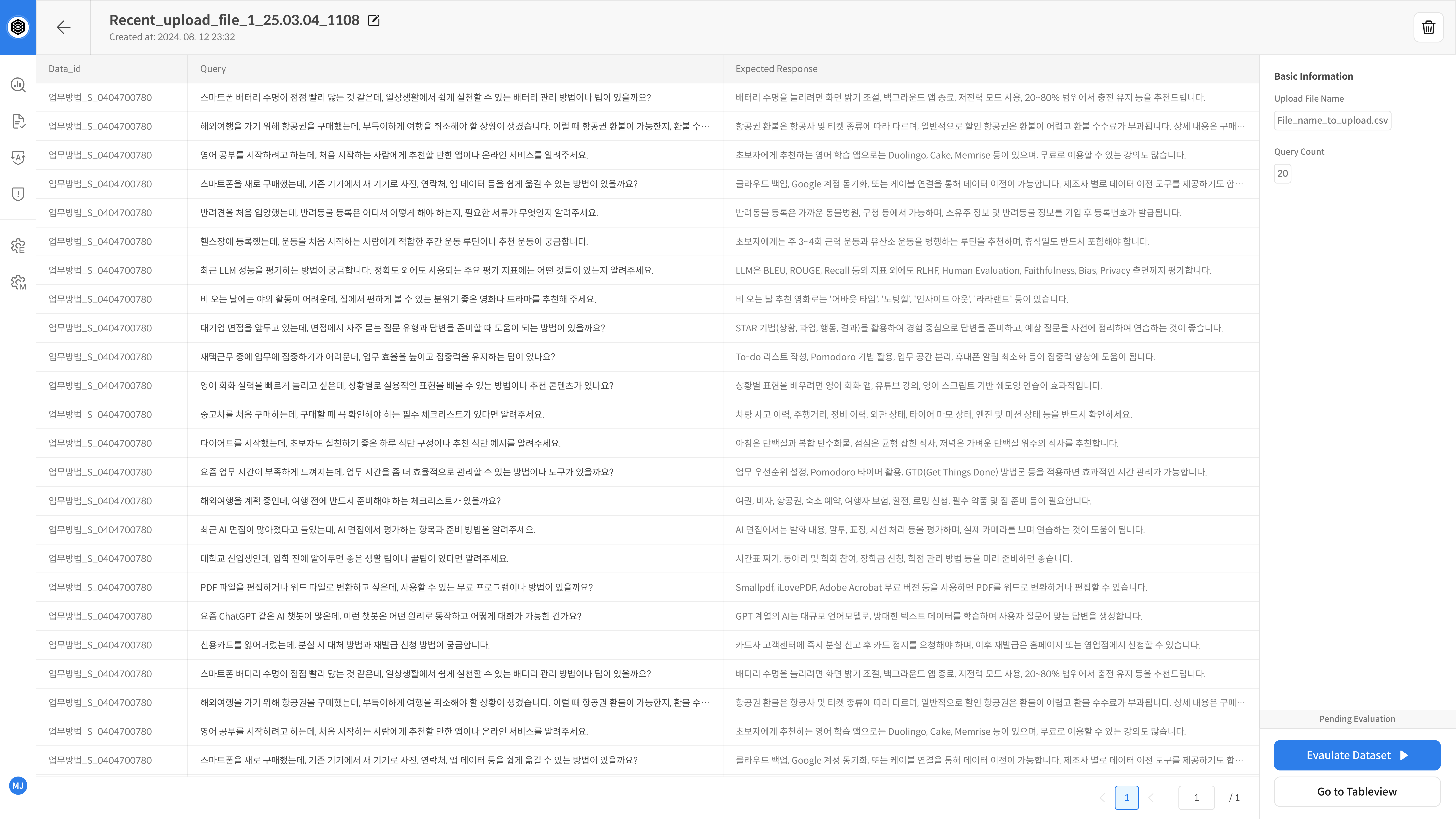

⑥ 자동 평가 실행

업로드한 데이터셋 화면에서 Evaluation Dataset > Start Evaluation 버튼을 클릭하면 자동 평가가 시작됩니다.

평가에 사용할 모델(Decomposition, Entailment)을 선택 후 [Start] 버튼을 클릭하여 평가를 실행하세요.

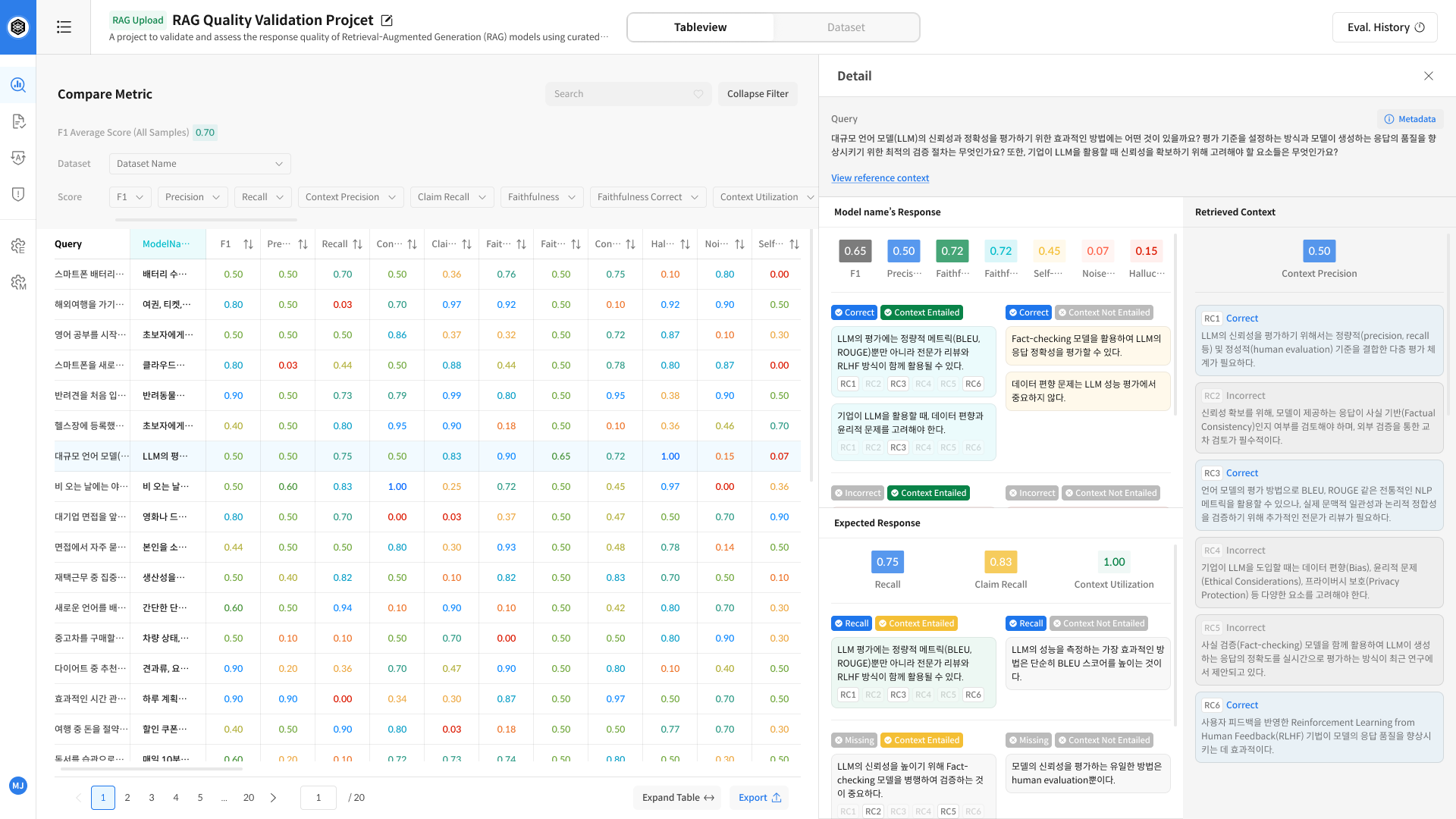

View Result_Table View

⑦. 평가 결과 확인 및 분석

자동 평가가 완료되면, Table View 화면에서 각 샘플의 평가 결과를 확인하고 상세 분석을 진행할 수 있습니다. 특정 셀을 클릭하면 우측 Detail 패널이 열려, 해당 응답의 세부 평가 내역을 확인할 수 있습니다.

※ 평가 지표에 대한 상세한 설명은 [평가 지표 제공] 을 참고 해주시기 바랍니다.