Metric Management Overview

Datumo Eval에는 여러 가지 기본 Metric이 제공됩니다. 하지만 각 사용 사례에 맞는 맞춤형 Metric을 만들어야 할 때가 있을 수 있습니다.

이 페이지에서는 나만의 Metric을 설정하고 관리하는 방법을 안내합니다. 기본적인 설정부터 고급 설정까지, 다양한 기능을 통해 자신만의 평가 기준을 정의할 수 있습니다.

여러분은 Metric 설정을 통해 AI 모델을 효과적으로 평가하고, 모델의 강점과 약점을 분석할 수 있습니다. 여기서는 Metric 정의, 스케일 추가, 루브릭 설정, 고급 프롬프트 생성까지 모든 기능을 다룹니다.

Metric Configuration

- Metric Management (기본) : 기본적인 Metric 설정과 루브릭 정의 방법을 다룹니다.

- Metric Management (Advanced) (고급) : 고급 사용자를 위한 프롬프트 생성 하여 나만의 Metric 생성 기능을 설명합니다.

Step-by-step

Step 1. 기본 설정 (Metric Management)

Datumo Eval에서 제공하는 기본 Metric(평가지표) 외에도, 사용자가 자신의 필요에 맞는 Metric을 생성할 수 있습니다.

나만의 평가지표 설정을 위해 다음 단계를 따릅니다 :

① 새로운 Metric 생성

기본적으로 제공되는 Metric 이외도, 새로운 Metric을 정의할 수 있습니다.

먼저 좌측 내비게이션 바에서 [Metric Management] 페이지를 열어주세요. 이 페이지에서 Metric(평가지표) 생성 및 관리 작업을 시작할 수 있습니다.

우측 상단의 [+ New Metric] 버튼을 클릭하면, 기본으로 제공되는 평가 방식을 선택할 수 있는 모달이 열립니다.

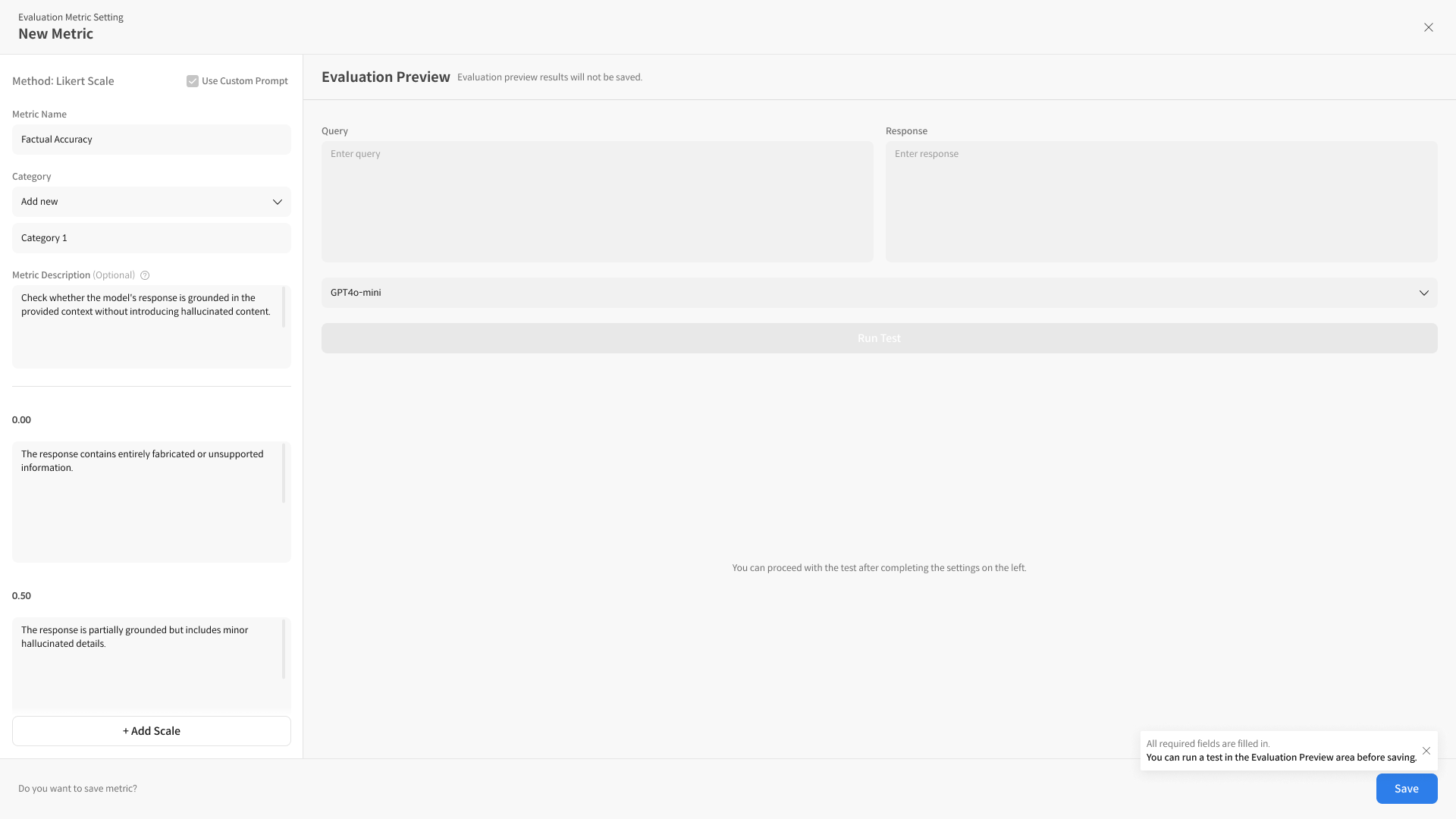

② 기본 정보 및 Rubric 구성

새로운 Metric을 생성하는 과정에서는 여러 항목을 설정해야 합니다.

이 과정에서 중요한 요소들은 Metric 이름, 카테고리(Category), Metric description, prompt description 등입니다.

필요 시 Rubric 항목은 자유롭게 추가/삭제할 수 있으며 다음은 화면 흐름에 따라 각 요소들이 의미하는 내용입니다 :

- Metric Name

- 새로운 Metric의 이름을 입력합니다. 이 이름은 모델 평가 기준으로 사용됩니다.

- 예: "정확도 평가", "사용자 만족도" 등.

- Category

- Metric을 카테고리로 분류하여 관리할 수 있습니다. 예를 들어, "모델 성능", "안전성 평가" 등으로 나누어 정리할 수 있습니다.

- Metric Description

- Metric 설명을 추가합니다. 사용자에게 보여지는 설명으로, 각 Metric이 어떤 기준을 평가하는지 간략하게 서술합니다.

- 예: "이 Metric은 모델의 정확도를 평가하는 지표입니다."

- Prompt Description

- 프롬프트 설명은 필수 항목으로, 해당 Metric을 평가할 때 사용할 프롬프트의 정의를 작성합니다.

- 이 설명은 Metric 루브릭에 반영되며, 평가를 위한 질문이 자동으로 생성될 때 사용됩니다.

- 예: "이 Metric은 모델의 응답 정확성을 평가하며, 사용자 요청에 대한 정확한 답변을 기준으로 평가합니다."

- Scale

- 각 Metric에 대한 평가 스케일을 설정합니다. 예를 들어 1~5점 또는 우수, 보통, 미흡 등의 스케일을 사용할 수 있습니다.

- 스케일을 설정한 후 각 점수에 대한 설명을 추가하여 평가 기준을 세부적으로 설정합니다.

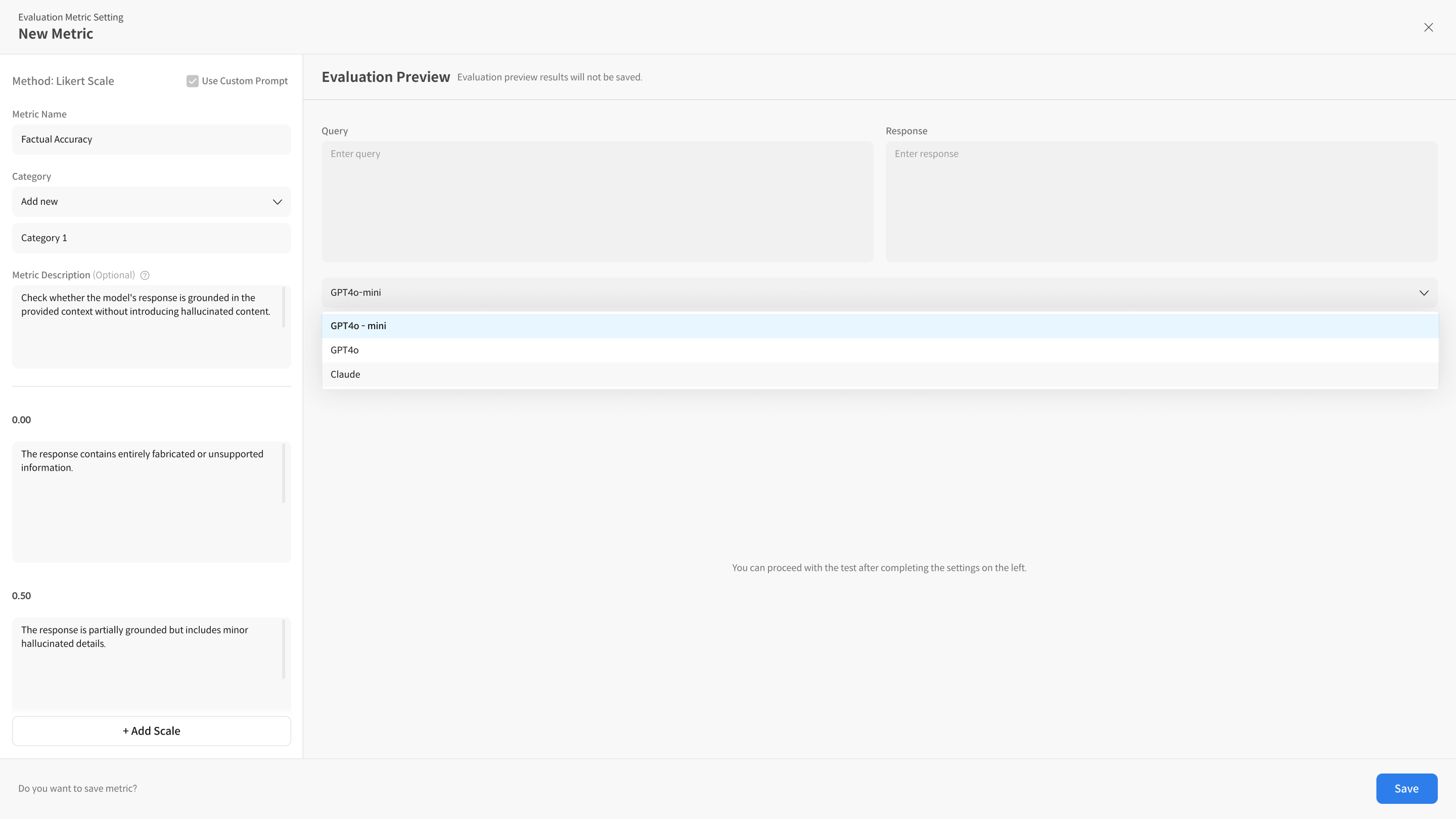

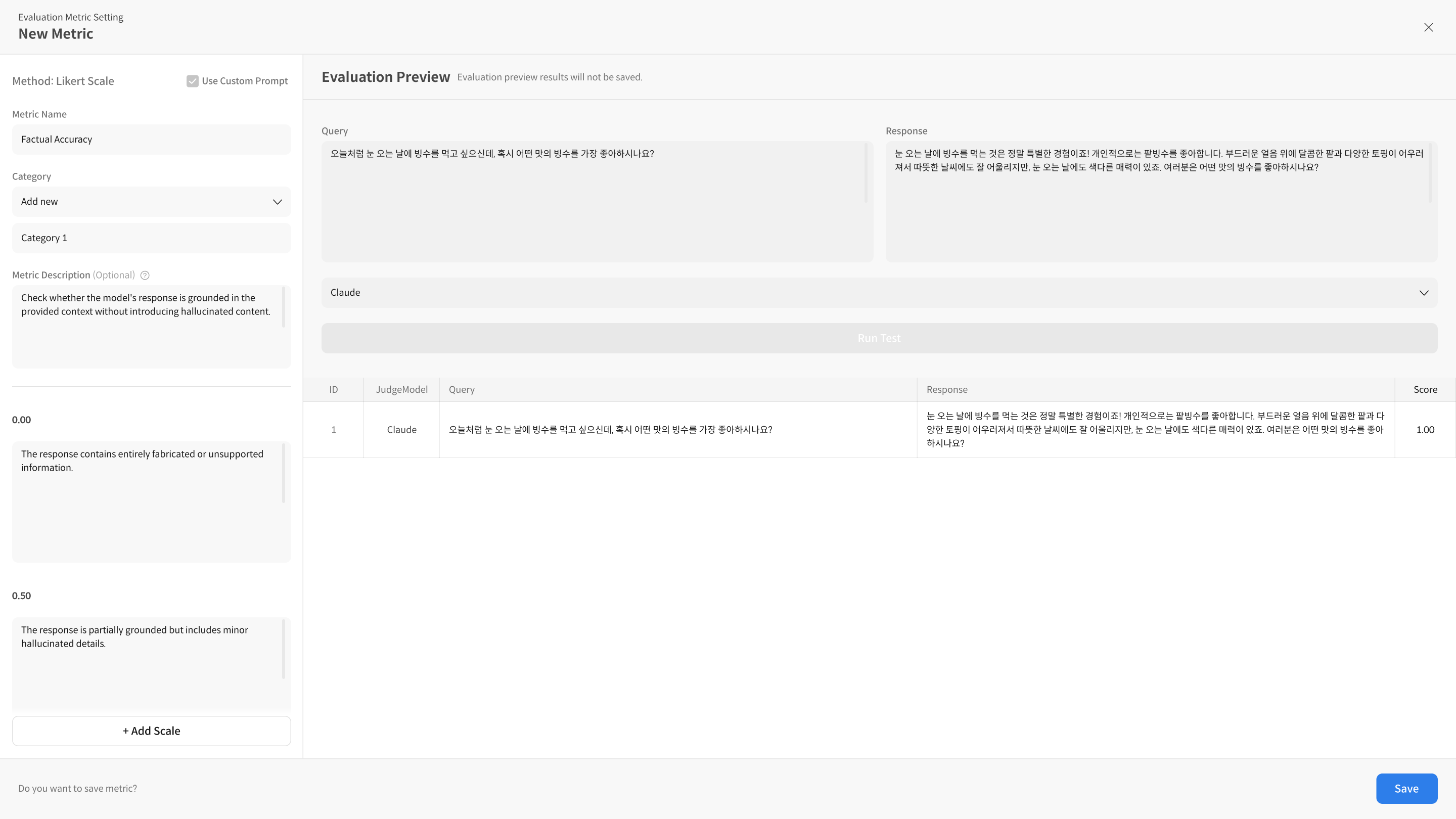

③ 평가 미리보기 (Run Test)

작성한 Rubric의 평가 기준이 의도대로 작동하는지 미리 확인해볼 수 있습니다.

Query, Response, (Optional) Context를 입력한 후 모델을 선택해 [Run Test]를 실행하세요.

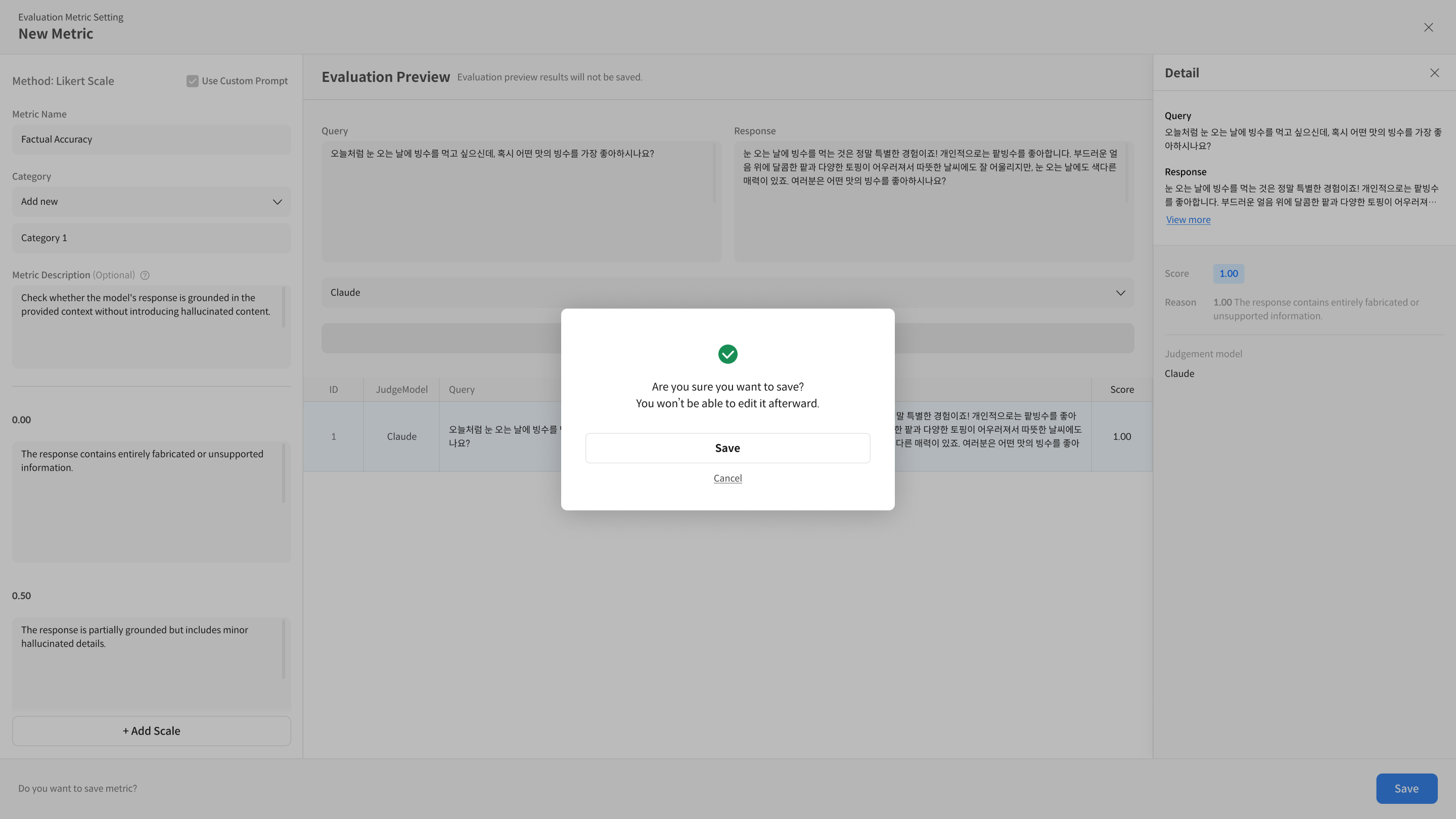

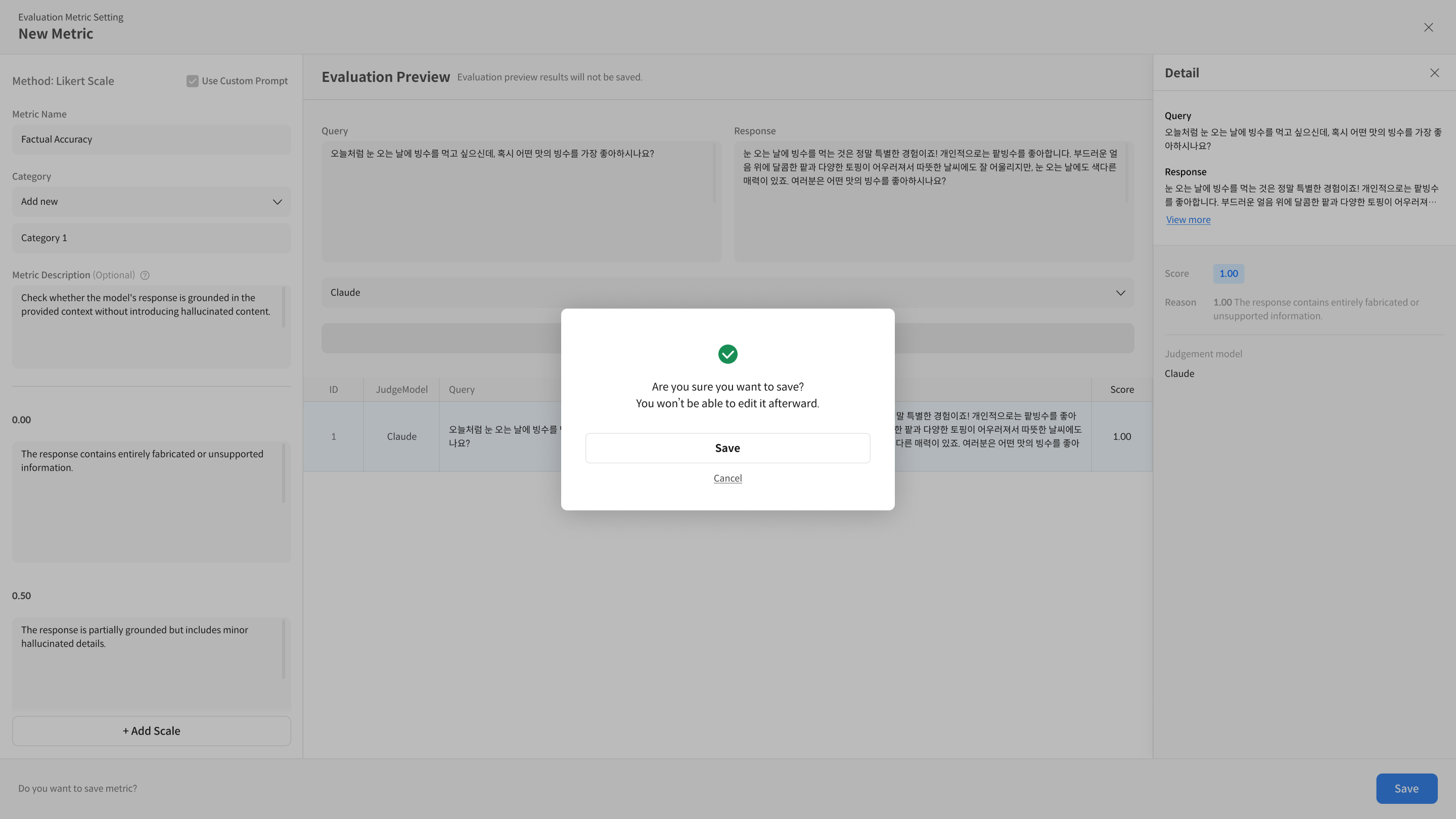

④ Metric 저장 및 활용

모든 설정을 완료했다면 [Save] 버튼을 클릭해 Metric을 저장합니다.

설정한 Metric은 저장하고, 추후 평가 시 사용할 수 있습니다.

저장 후, Metric 상세 화면에서 생성 시 진행 했던 것 처럼 평가 테스트까지 진행할 수 있습니다.

Step 2. 고급 설정 (Use Custom Prompt)

Datumo Eval에서 제공하는 기본 프롬프트가 있지만, 사용 사례에 맞게 프롬프트부터 맞춤형 지표를 만들어야 할 수도 있습니다.

Use Custom Prompt를 활용하여 프롬프트부터 매트릭을 설정할 수 있습니다.

Use Custom Prompt는 기본 New Metric 기능이 이미 익숙한 사용자를 위한 기능입니다.

그렇지 않다면, 진행 전 [Step 1. 기본 설정] 내용을 다시 살펴보세요.

고급 설정의 빠른 흐름은 다음과 같습니다:

1단계: Use Custom Prompt 옵션을 선택하여 custom metric 기능을 활성화합니다.

2단계: 루브릭(Scale) 및 프롬프트 내용 입력합니다.

3단계: Metric이 정상적으로 작동하는지 Run Test로 확인합니다.

4단계: 저장합니다

- 점수 스케일은 Scale 탭에 있는 Scale Prompt에 자동으로 입력됩니다.

- 점수 스케일과 출력 형식은 고정되어 수정 불가합니다.

※ 출력 형식은 블라인드 처리되어 있으며, 수정할 수 없습니다. - 필수 컬럼 외 사용자 프롬프트 (User Prompt)에서 다른 컬럼, 즉 metadata를 프롬프트에서 활용하고 싶다면

{{}}내에 입력하여 사용하면 됩니다.

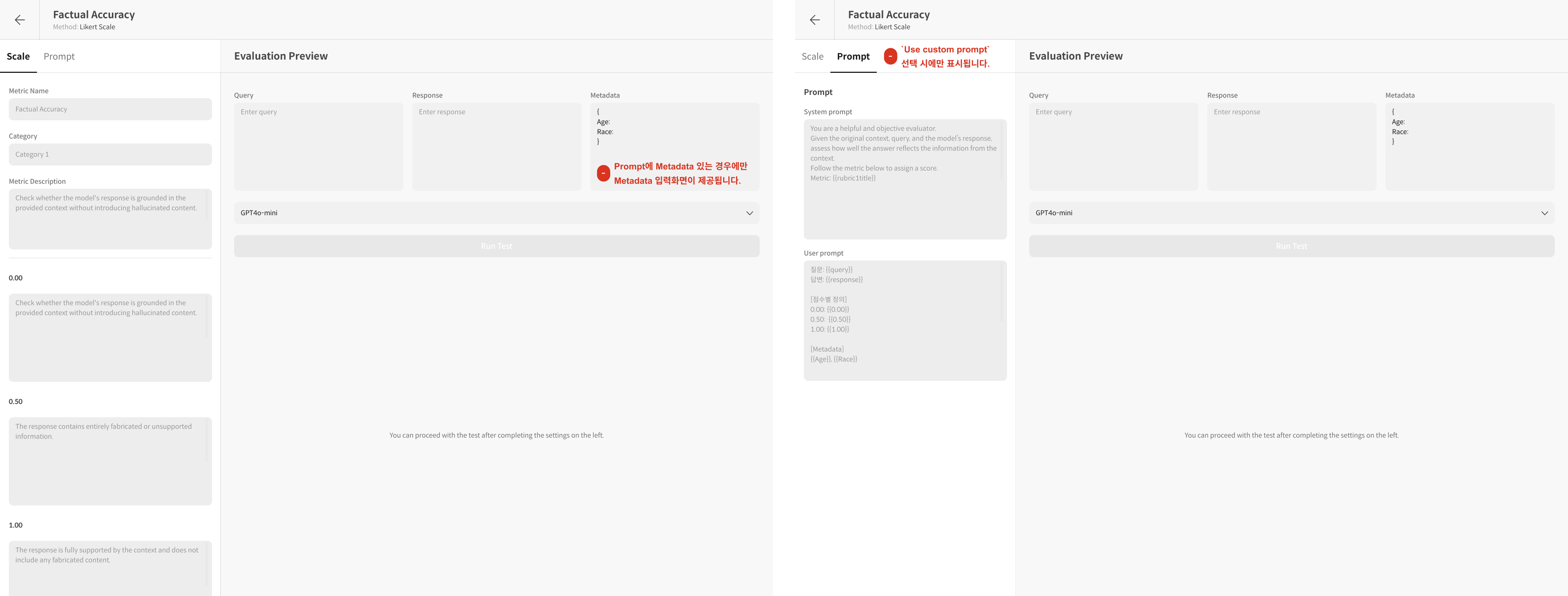

① Use Custom Prompt 옵션을 선택합니다.

② 루브릭(Scale) 및 프롬프트 내용 입력합니다.

-

2-1. Scale Tab

-

Metric Name : 생성할 Metric의 이름을 입력합니다.

-

Category : Metric을 분류기준으로 카테고리로 묶인 매트릭은 대시보드에서 평균 점수를 확인할 수 있습니다.

-

Metric Description : Metric 설명을 추가합니다. 대시보드에서 해당 Metric에 대한 설명이 표시됩니다.

-예: "이 Metric은 모델의 정확도를 평가하는 지표입니다." -

Prompt Description : Prompt 설명은 필수 항목입니다. 해당 Metric을 평가할 때 사용할 프롬프트의 정의를 작성합니다.

이 설명은 Metric 루브릭에 반영되며, 평가를 위한 질문이 자동으로 생성될 때 사용됩니다.

-예: "이 Metric은 모델의 응답 정확성을 평가하며, 사용자 요청에 대한 정확한 답변을 기준으로 평가합니다." -

Scale : 점수 스케일(루브릭)을 설계하는 영역입니다.

-점수 1 : 프롬프트에 입력되는 스케일로 정수1부터 n까지자동으로 입력됩니다. 대시보드에 표기되는 최종 스코어는evaluated as 0.00으로 확인 가능합니다.

-description 1: 루브릭에 대한 상세 설명을 입력하세요.Prompt와Scale Prompt에서 반영여부를 확인할 수 있습니다.

-+ Add scale: binary한 루브릭이 아닌 여러 루브릭 체계가 있다면 scale을 추가하여 루브릭을 설정해주세요.

-

-

2-2. Prompt 탭: 프롬프트 상세 설정 이 탭에서는 평가 모델(Judge Model)이 응답을 평가할 때 사용할 프롬프트를 직접 작성하고 제어합니다. 프롬프트는 System Prompt와 User Prompt로 구성됩니다.

-

System Prompt

- 역할: 평가 모델의 역할이나 페르소나를 정의합니다. 이 프롬프트는 모델에게 어떤 관점에서 평가를 수행해야 하는지 알려주는 중요한 지침이 됩니다.

- 예시:

You are a fair and objective AI assistant, designed to evaluate text based on a given set of criteria.

-

User Prompt

- 역할: 실제 평가에 사용될 데이터와 평가 기준을 설정합니다.

{{변수명}}을 사용하여 데이터셋의 값을 프롬프트에 반영합니다. - 필수 값:

{{query}}: 평가에 사용되는 질문 데이터입니다.{{response}}: 평가하고자 하는 모델의 응답입니다.{{desc}}: Prompt description에서 정의한 루브릭의 정의(평가 기준)로 변수만 입력하면 자동으로 반영됩니다.

- 선택 사항:

{{context}}: 질문 생성 시 참고한 Reference context 입니다.{{retrieved_context}}: RAG 평가 등에서 사용된 검색된 문서입니다.

- 작성 예시:

### Instruction

Please evaluate the provided "Response to Evaluate" based on the "Query" and the "Evaluation Criteria (Rubric)". If "Retrieved Context" is available, consider it to assess for issues like hallucination.

### Query

{{query}}

### Retrieved Context

{{retrieved_context}}

### Response to Evaluate

{{response}}

### Evaluation Criteria (Rubric)

{{desc}}

- 역할: 실제 평가에 사용될 데이터와 평가 기준을 설정합니다.

-

Scale Prompt (수정불가)

- 이 프롬프트는 별도로 작성하는 것이 아니라, Scale 탭에서 Prompt description에서 설정한 루브릭의 정의가

{{desc}}변수를 통해 User Prompt에 자동으로 삽입된 결과를 보여줍니다. 이를 통해 루브릭의 점수 스캐일이 어떻게 적용되는지 확인 할 수 있습니다.

- 이 프롬프트는 별도로 작성하는 것이 아니라, Scale 탭에서 Prompt description에서 설정한 루브릭의 정의가

-

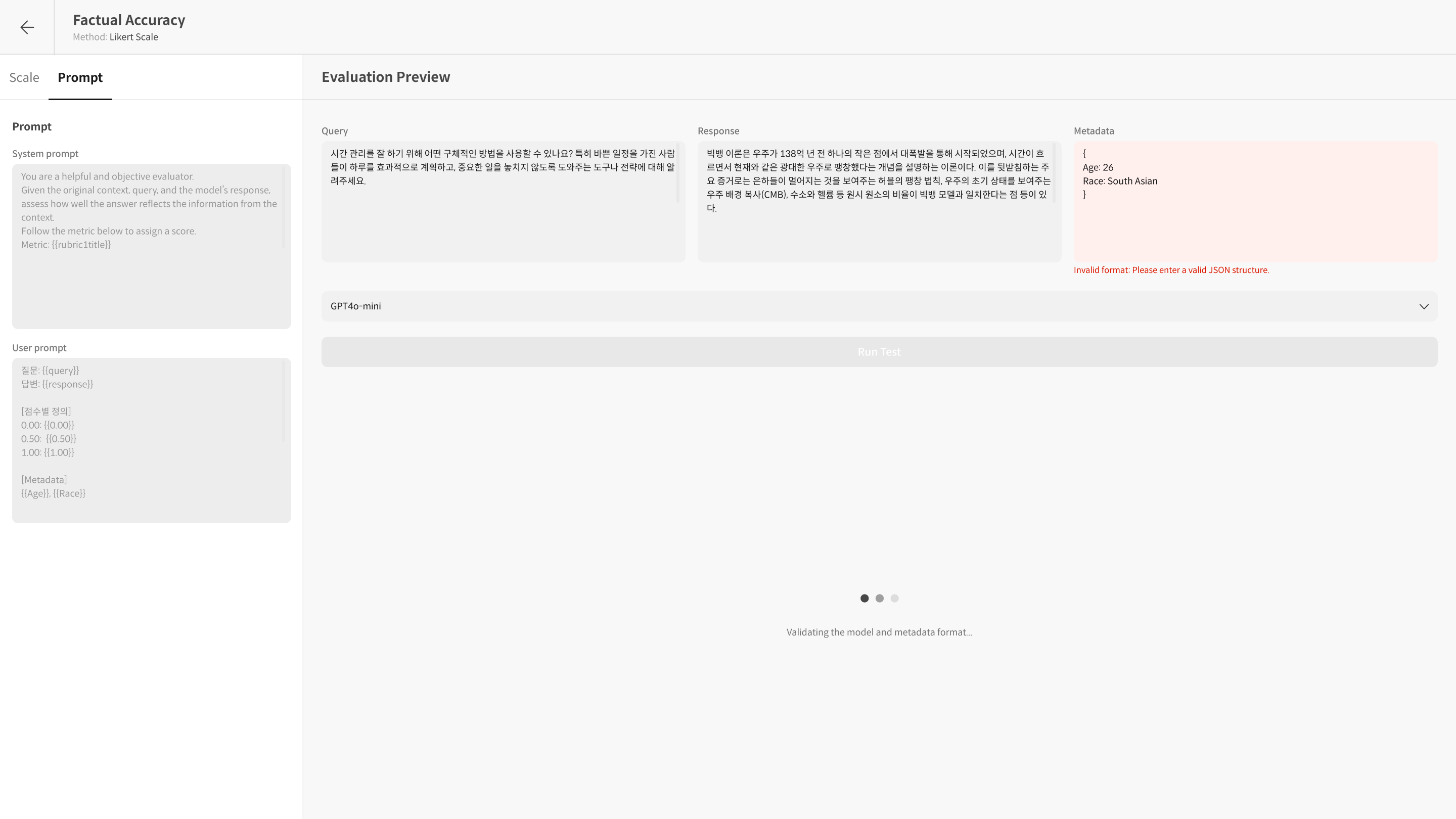

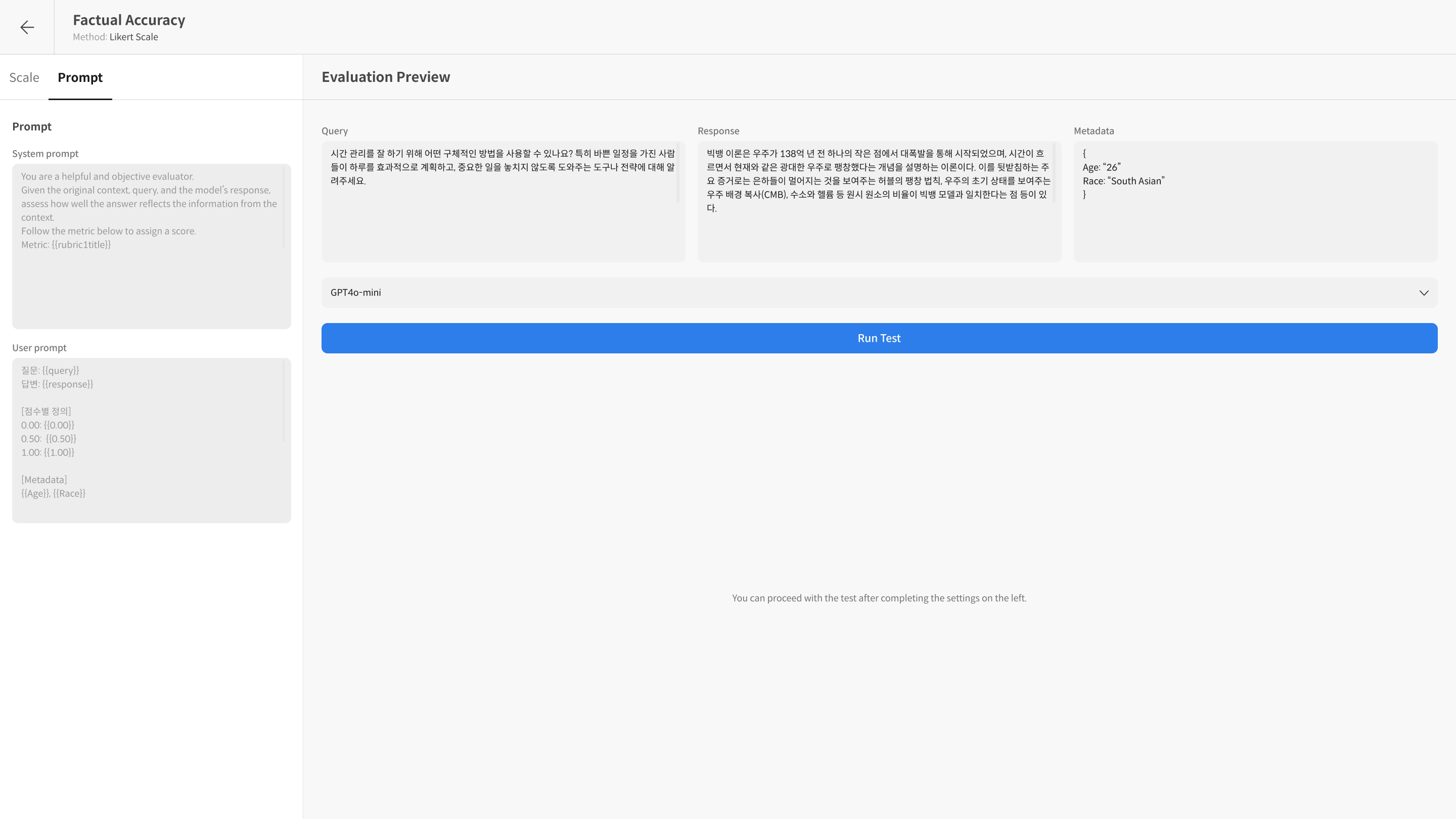

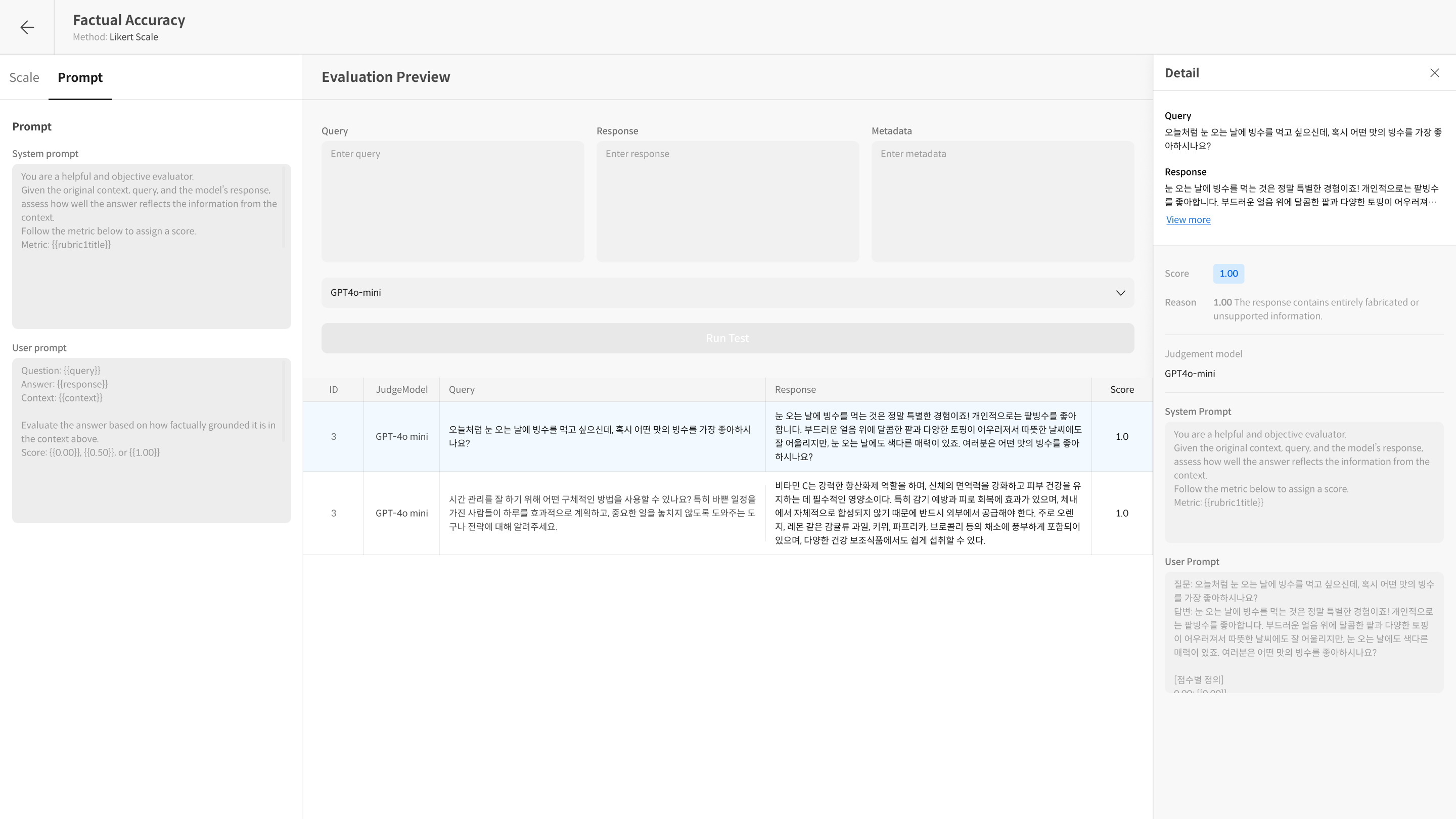

③ Run Test로 확인

입력한 프롬프트가 정상적으로 작동하는지 확인하려면, Run Test 후 Detail에서 실제 모델에 어떻게 입력되는지 확인할 수 있습니다.

Run Test는 작성한 Metric을 테스트하여 해당 프롬프트와 설정이 의도대로 작동하는지 점검하는 기능입니다.

- 항목별 점수와 함께, 적용된 프롬프트 내용과 모델의 reasoning을 보여줍니다.

- 프롬프트를 수정하면서 테스트를 반복해볼 수 있습니다.

- Evaluation Preview Tab

④ 저장

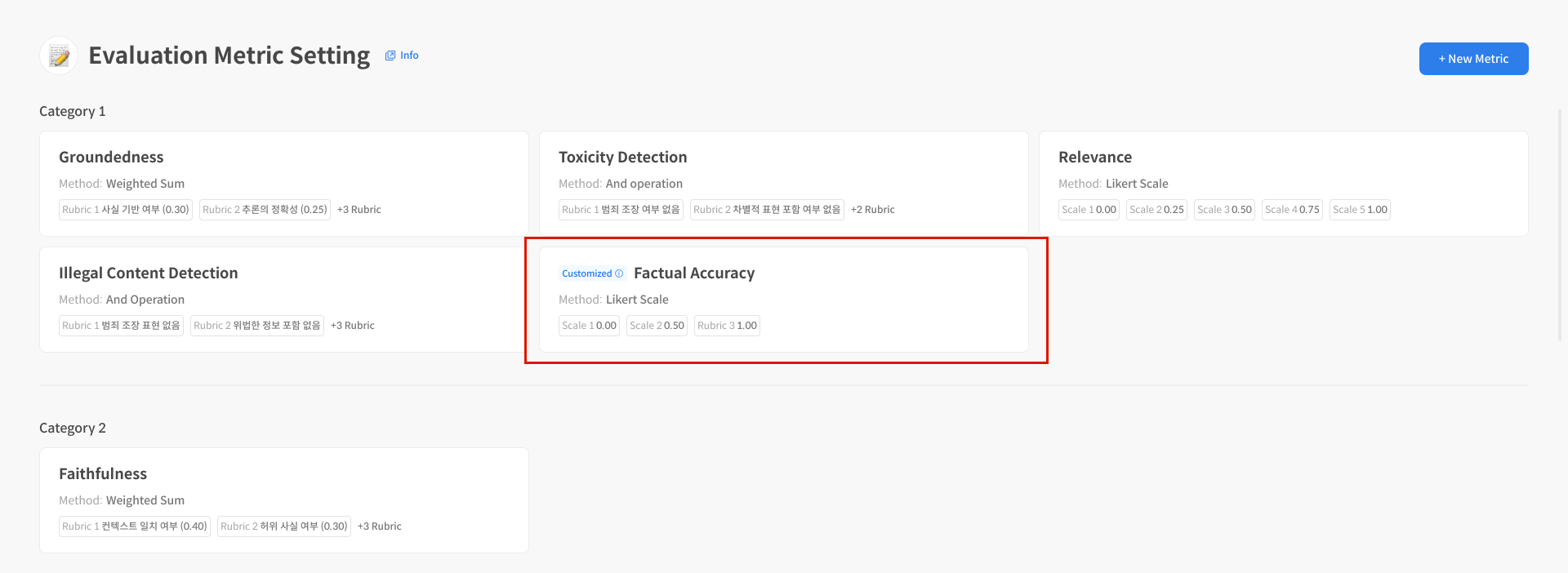

프롬프트 설정을 완료한 후, Metric을 저장하고 적용하여 실제 평가에 사용할 수 있습니다.

저장 후, 생성된 Metric은 대시보드에서 확인할 수 있으며, 후속 평가에서 사용할 수 있습니다.

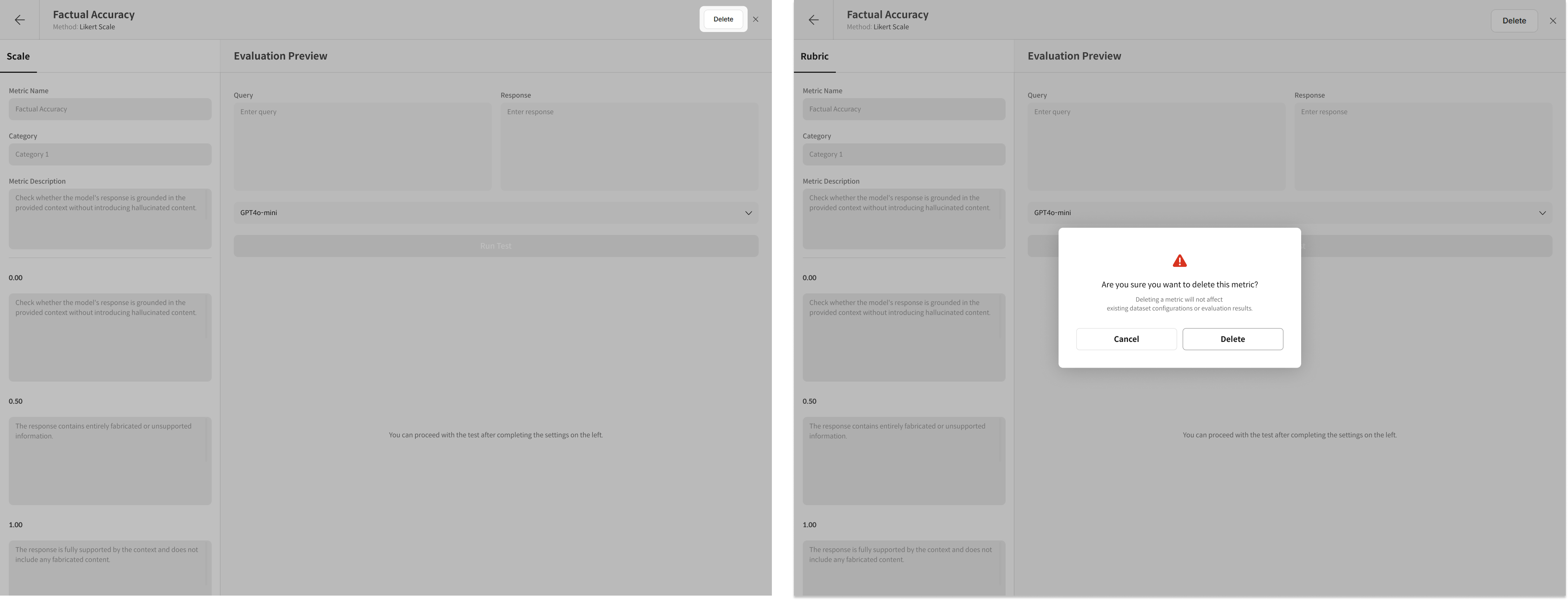

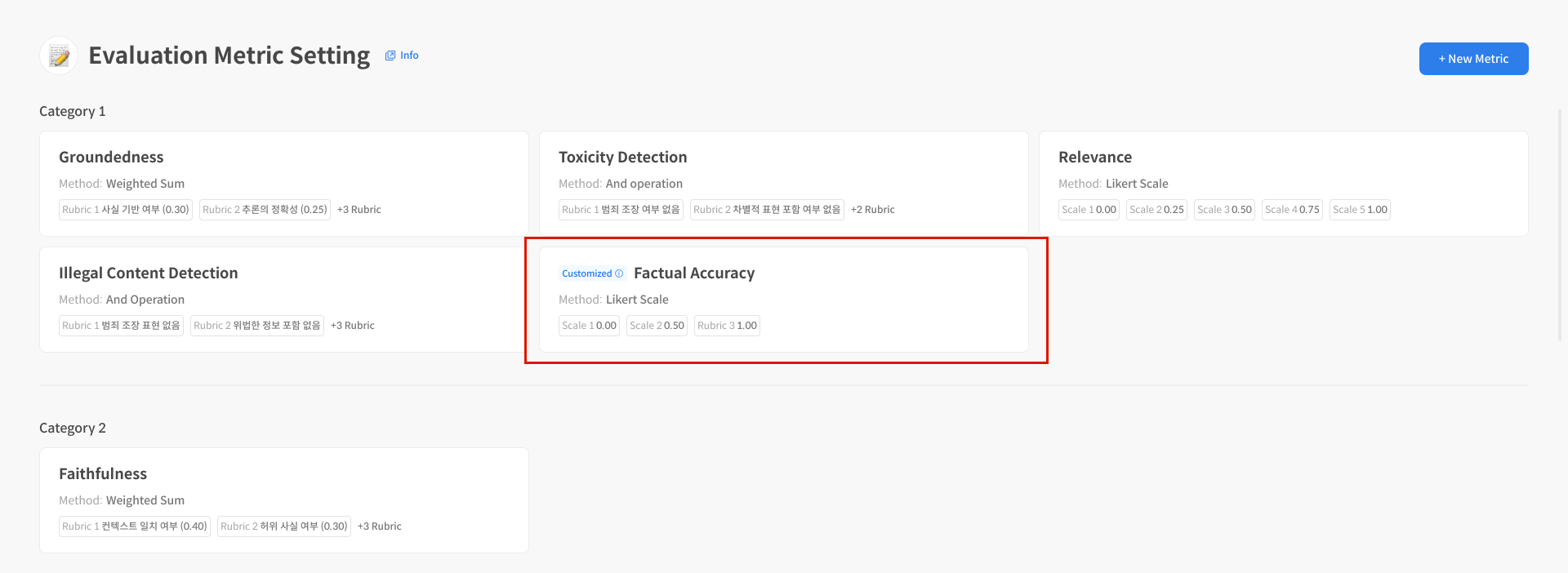

Step 3. Metric 관리 기능

생성한 Metric을 선택하면, 해당 Metric의 상세 페이지로 이동합니다. 이 페이지에서는 다음과 같은 기능을 사용할 수 있습니다:

- Metric Detail 화면 설명

- Metric 삭제

- Preview Run Test

① Metric 상세 화면 안내

Use custom prompt 사용 여부에 따라 표시되는 항목이 달라집니다.② Preview Run Test

각 Metric에 대해 미리보기 평가(Preview Run)를 실행해볼 수 있습니다.

실제 평가 전에 테스트 결과를 확인할 수 있어, 설정한 평가 기준이 잘 작동하는지 검증할 수 있습니다.

- Run Test 실행 전, 필요한 경우 Metadata 값을 입력해야 합니다.

- `Preview Run을 통해 설정한 평가 기준을 테스트할 수 있습니다.

평가가 완료된 데이터는 점수뿐 아니라 데이터 선택 시 세부 평가 사유까지 확인할 수 있습니다.

③ Metric 삭제

생성한 Metric은 리스트에서 개별 삭제할 수 있습니다. 삭제된 Metric은 복구할 수 없으니 주의하세요. 단, 이미 수행된 평가 결과에는 영향을 주지 않습니다.