Step 2. 자동 평가 실행하기

overview

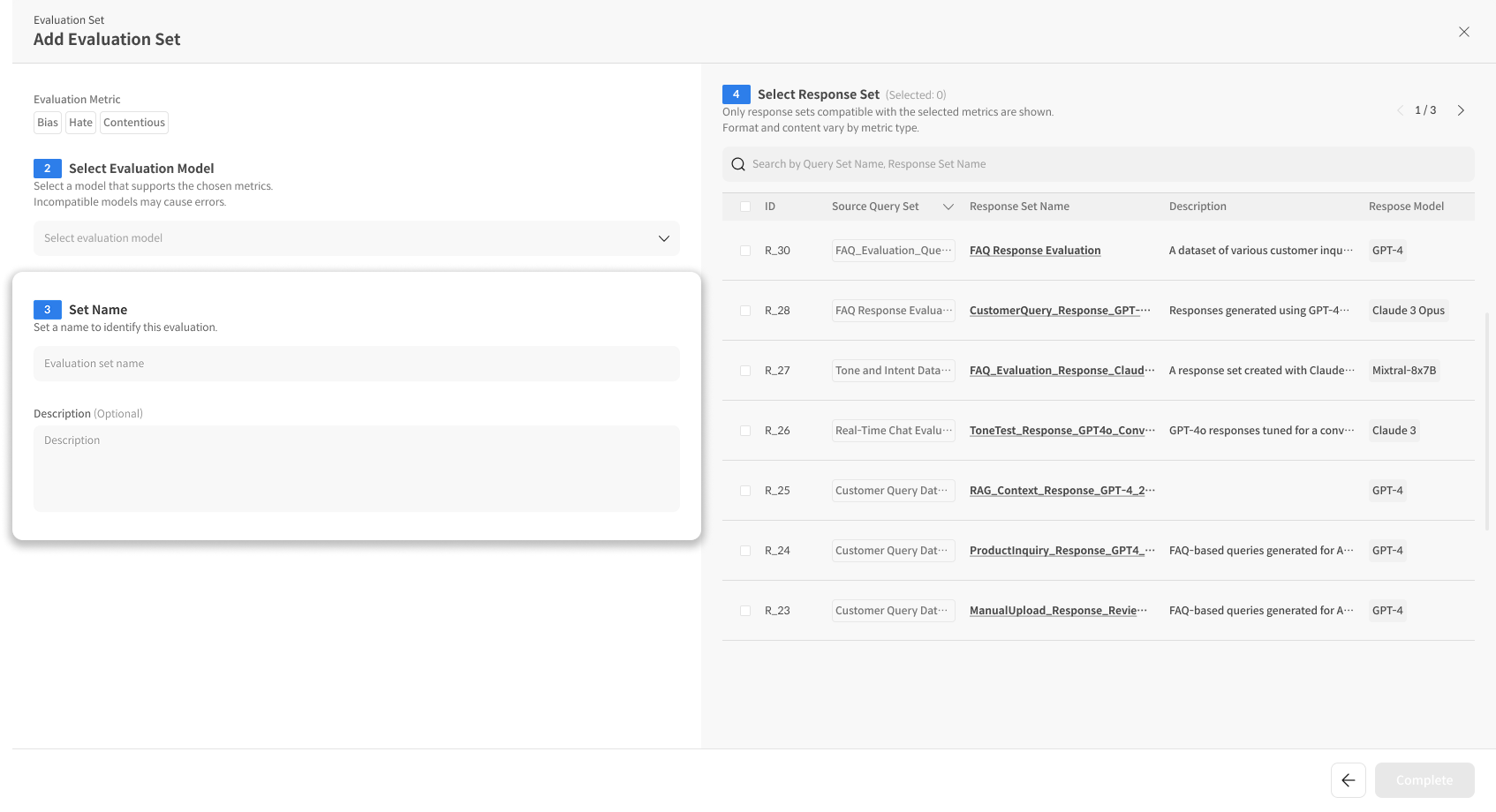

Evaluation Set은 하나의 모달에서 모든 평가 설정을 연속으로 진행하며, Set 생성 완료와 동시에 평가가 실행됩니다.

전체 흐름은 4단계 순서로 :

Metric 선택 → 평가 모델 설정 → Eval Set Name 입력 → 평가 대상 데이터셋(Response Set) 선택으로 진행됩니다.

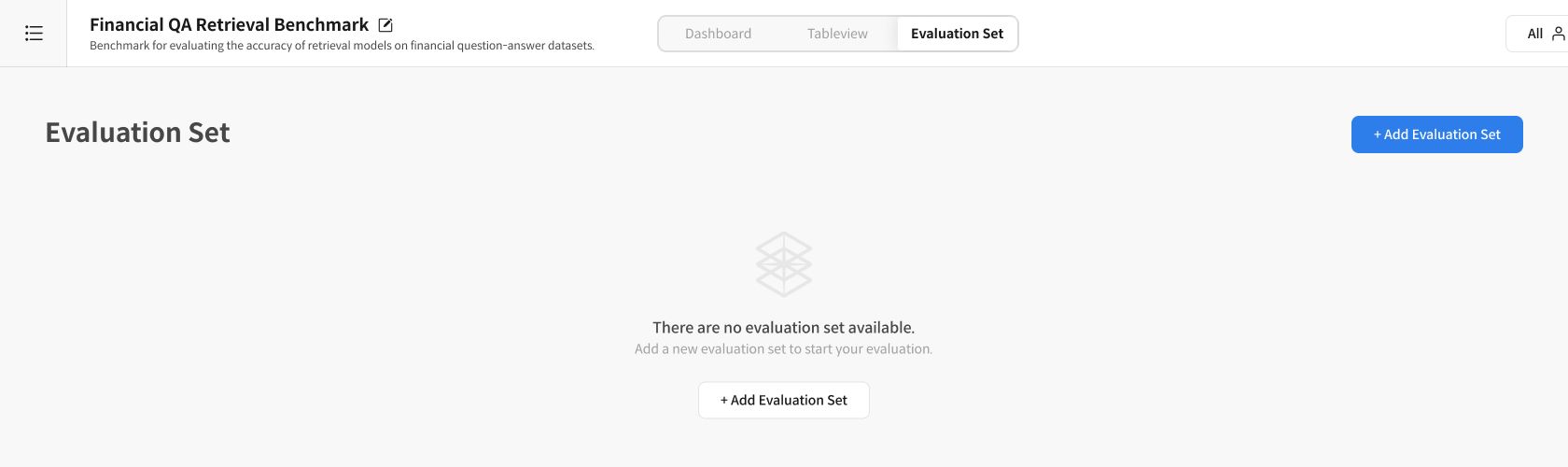

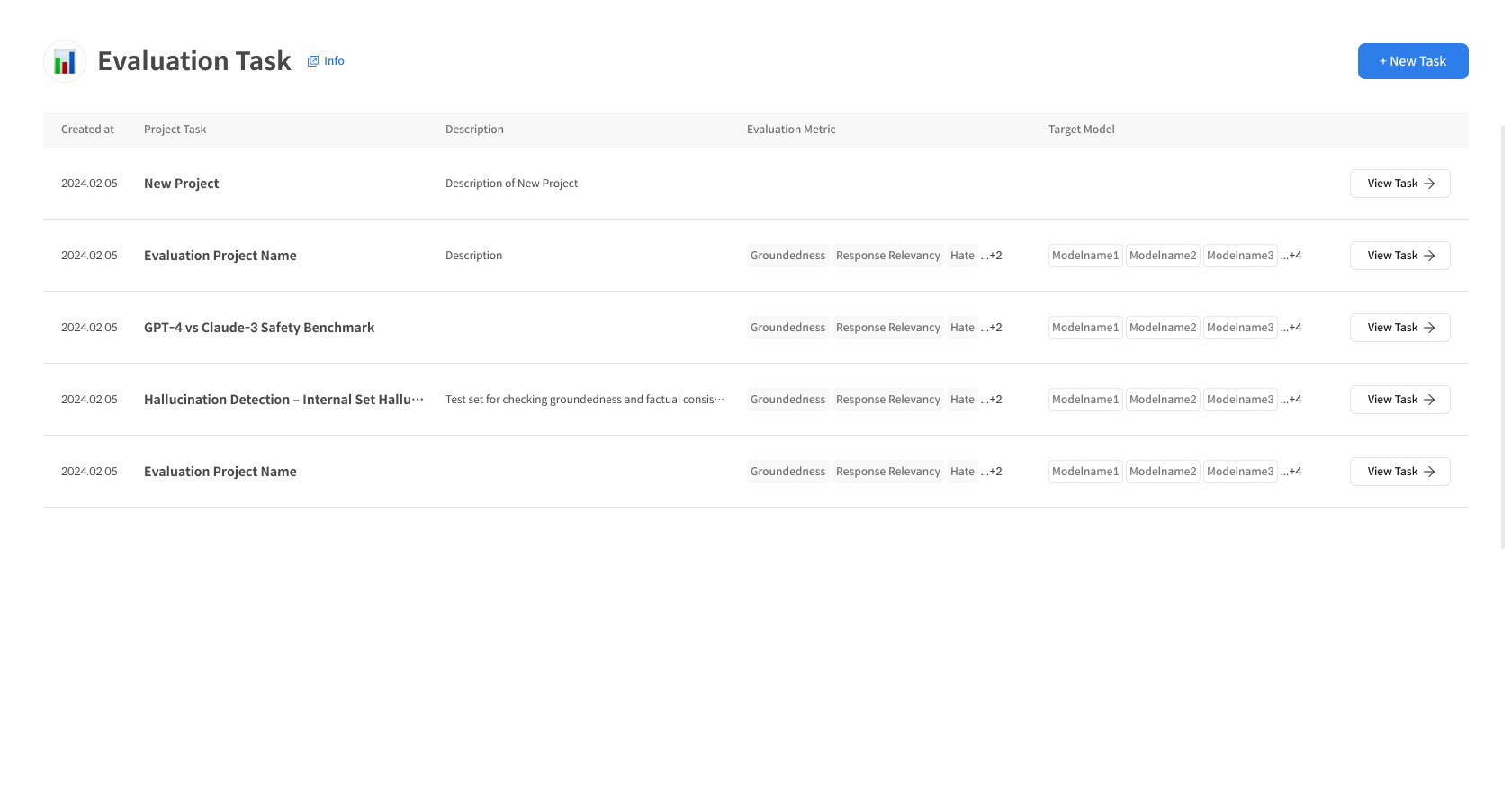

2-1. Eval Set 생성 시작

① Add Evaluation Set 버튼 클릭

- Task 생성 완료 후 「Add Evaluation Set」 버튼 클릭

- 평가 설정 모달이 열립니다

2-2.Eval Set 평가 설정

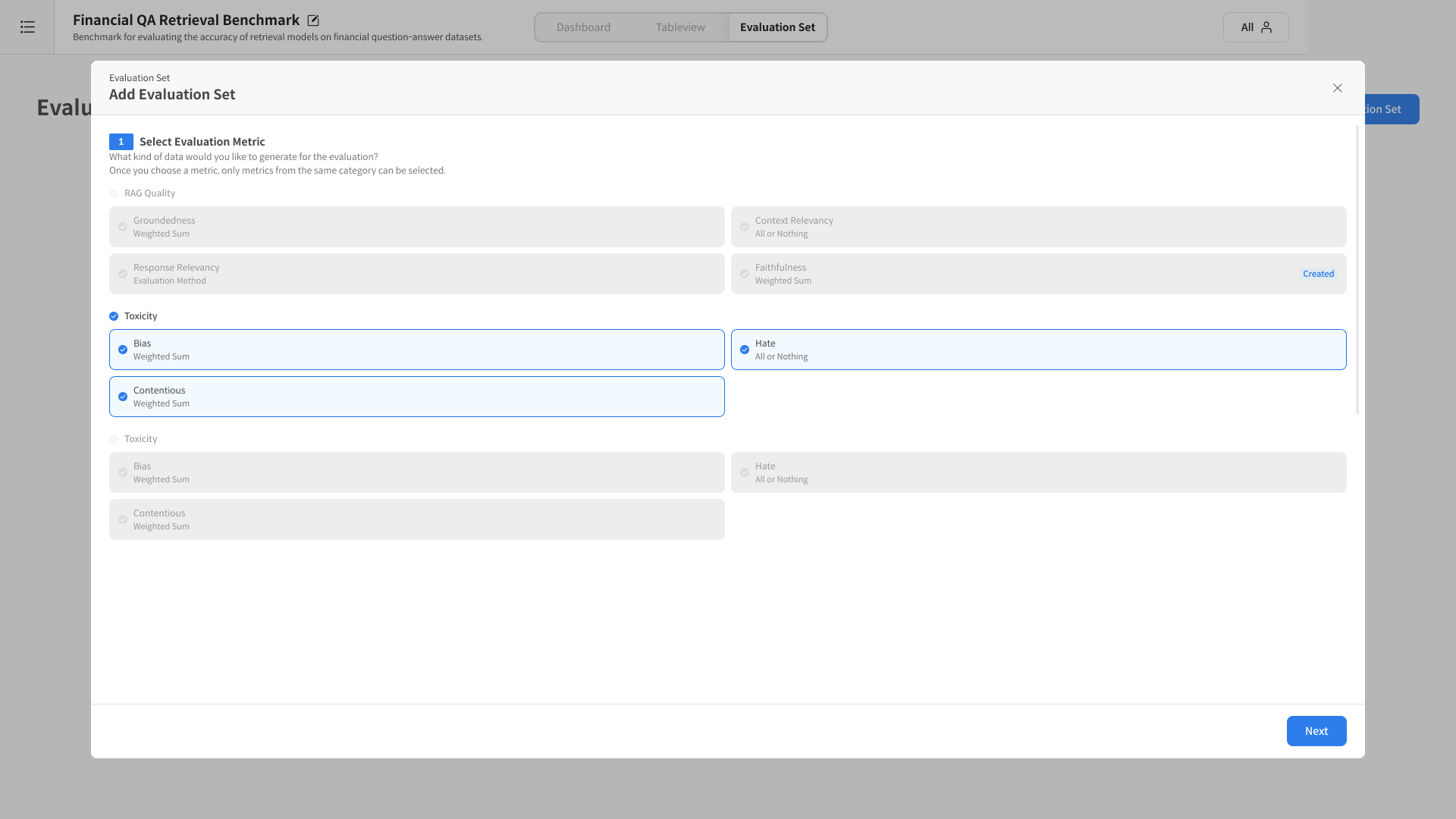

① Select Evaluation Metric

평가에 사용할 Metric을 선택합니다:

- Metric 카테고리 선택: 한 번 선택하면 동일 카테고리의 Metric만 선택 가능

- 선택한 Metric에 따라 호환되는 모델과 Response Set이 결정됨

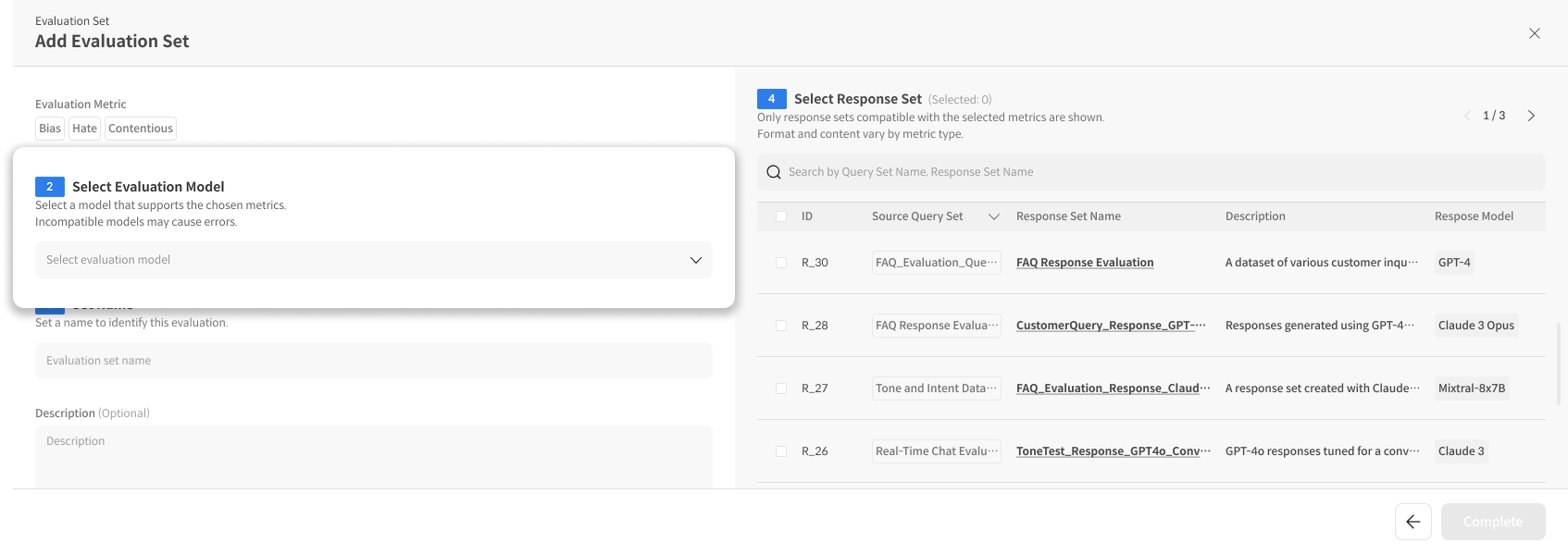

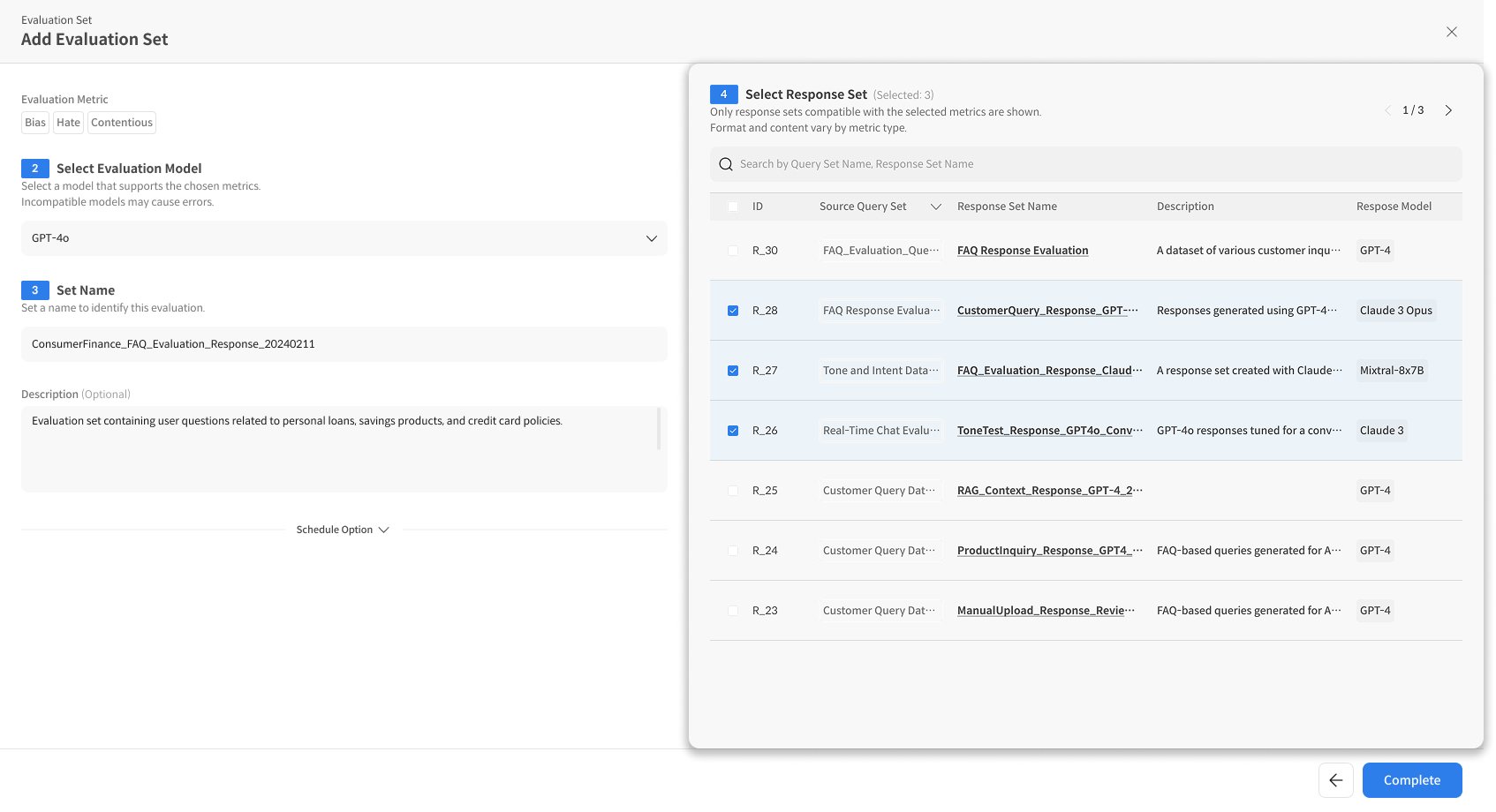

② Select Evaluation Model

선택한 Metric을 지원하는 평가 모델을 선택합니다:

- 호환 모델만 표시: 선택한 Metric과 호환되는 모델만 노출

- Judge Model 선택: GPT-4o, Claude 3.5 등

- 비호환 모델 선택 시 오류 발생 가능성 안내

③ Set Name

평가를 식별할 이름을 설정합니다:

- Evaluation Name: 평가 세트 이름 입력

- Description: 평가 목적이나 특징 설명 (선택사항)

④ Select Response Set

선택한 Metric과 호환되는 Response Set을 선택합니다:

- 호환 Response Set만 표시: 선택한 Metric과 호환되는 Response Set만 표시됩니다.

- 현재 선택된 Response Set 개수는 Selected: 0에서 확인할 수 있습니다.

⑤ Complete 실행

모든 설정 완료 후:

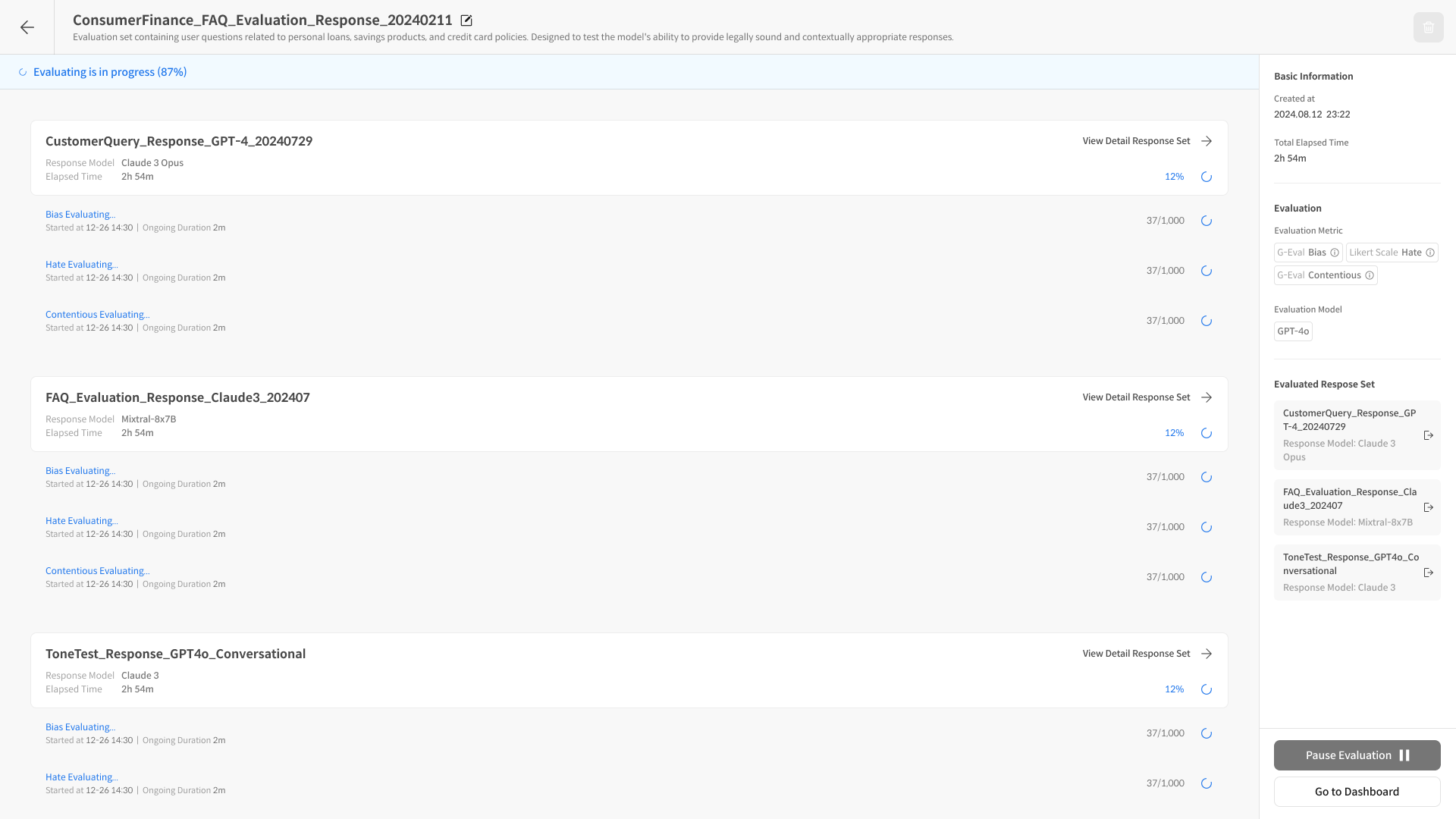

- Complete 버튼 클릭 즉시 평가가 시작됩니다.

- Eval Set Detail Page로 자동 이동: 평가 진행 상황을 실시간 확인할 수 있습니다.

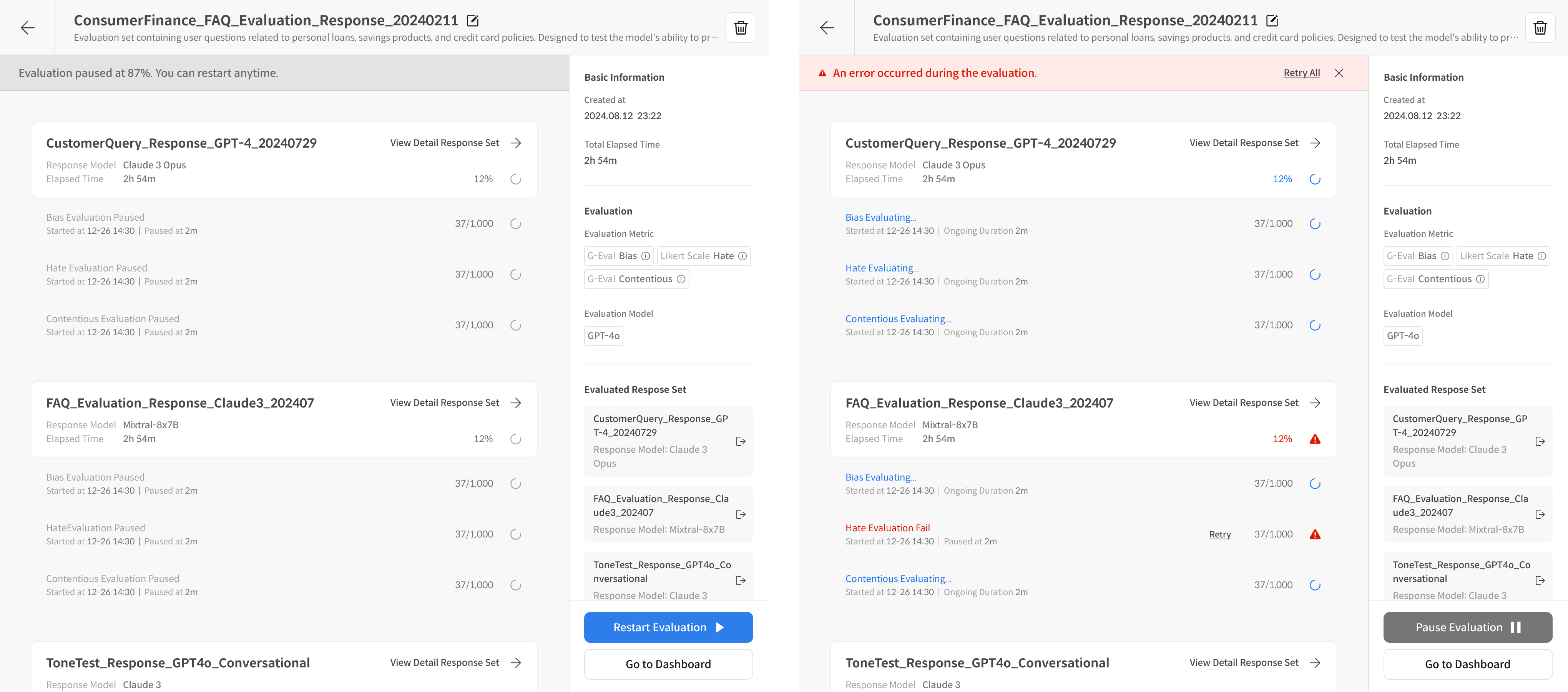

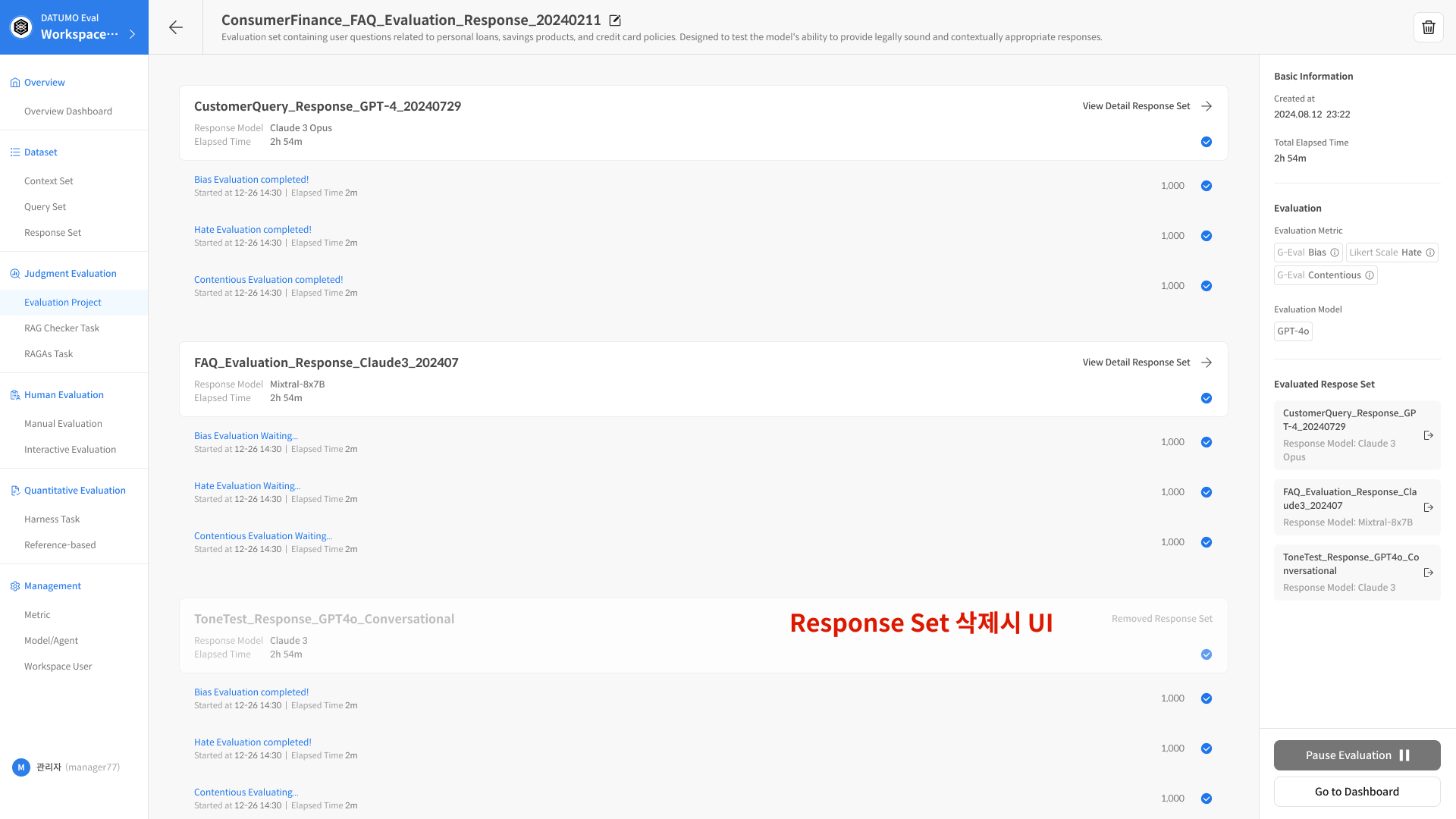

Evaluation Set에서 평가 관리가 가능합니다.

- Paused : 평가 paused 버튼을 통하며 평가를 중지하고 중지 된 시점부터 평가를 재시작 할 수 있습니다.

- Error : 평가 도중 Error 발생 시, 해당 데이터만 평가를 재시도 할 수 있습니다. 에러난 데이터 제외한 다른 데이터는 평가 결과에서 확인 할 수 있습니다.

2-3. 평가 완료

① 평가 완료

- 평가 완료 시 대시보드에서 바로 확인이 가능하며 전체 완료률 및 소요 시간 도 확인 할 수 있습니다.

💡 평가 진행 팁

1. Dataset 품질 검토

- 평가 전 반드시 Context와 Query 품질 확인

- 평가 목적에 맞는 질문 구성 확인

2. Metric 설정 최적화

- 평가 목적에 맞는 Metric 선택

- 호환성 확인: 선택한 Metric과 모델, Response Set 호환성

- Judge Model 성능과 비용 고려

3. 효율적인 평가 실행

- 소규모 테스트 먼저 진행 후 전체 평가

- 배치 크기 조정으로 안정성과 속도 균형

- 오류 발생 시 즉시 원인 파악 및 해결

❓ 자주 묻는 질문 (FAQ)

Q. 평가 중에 중단하면 어떻게 되나요?

A. 평가 도중 중단해도 이미 완료된 결과는 보존됩니다.

중단 시점부터 다시 시작할 수 있으며, 대시보드에서 부분 결과도 확인 가능합니다.

Q. 다른 카테고리의 Metric을 함께 사용할 수 있나요?

A. 한 번 Metric 카테고리를 선택하면 동일 카테고리의 Metric만 추가 가능합니다. 다른 카테고리를 사용하려면 새로운 Evaluation Set을 생성해야 합니다.

Q. 평가 결과를 수정할 수 있나요?

A. 평가 완료 후 개별 결과를 수동으로 수정할 수 있습니다. 자동 평가에서 놓친 부분이나 판단이 애매한 경우 사람이 직접 보정할 수 있습니다.