Manual Evaluation Guide

Manual Evaluation은 사람이 직접 AI 모델의 응답 품질을 평가·관리하는 워크플로우입니다.

**작업자(Worker)**와 검수자(Reviewer) 협업으로 체계적인 품질 관리와 Gold Response 선정이 가능합니다.

전체 Flow는 다음과 같습니다:

- Task 생성: 검수자가 Manual Evaluation 생성, Dataset/Metric 지정

- 평가 진행: 작업자 홈에서 Task 선택 → 루브릭 평가 → Submit/Skip

- 검수/분석: 검수자가 TableView에서 Gold 관리, 대시보드로 성능 비교

역할별 주요 기능:

- 작업자: 평가/제출 전용, Gold는 마지막 단계에서 선택 입력

- 검수자: TableView로 Query별 점수/Gold 관리, Dashboard 분석

검수자 (Reviewer) ① — 작업생성

검수자는 Task 생성부터 분석까지 전체 평가 프로세스를 관리합니다.

이 섹션에서는 Task 생성과 Eval Set 관리하는 방법을 안내합니다.

Step 1. Task 생성

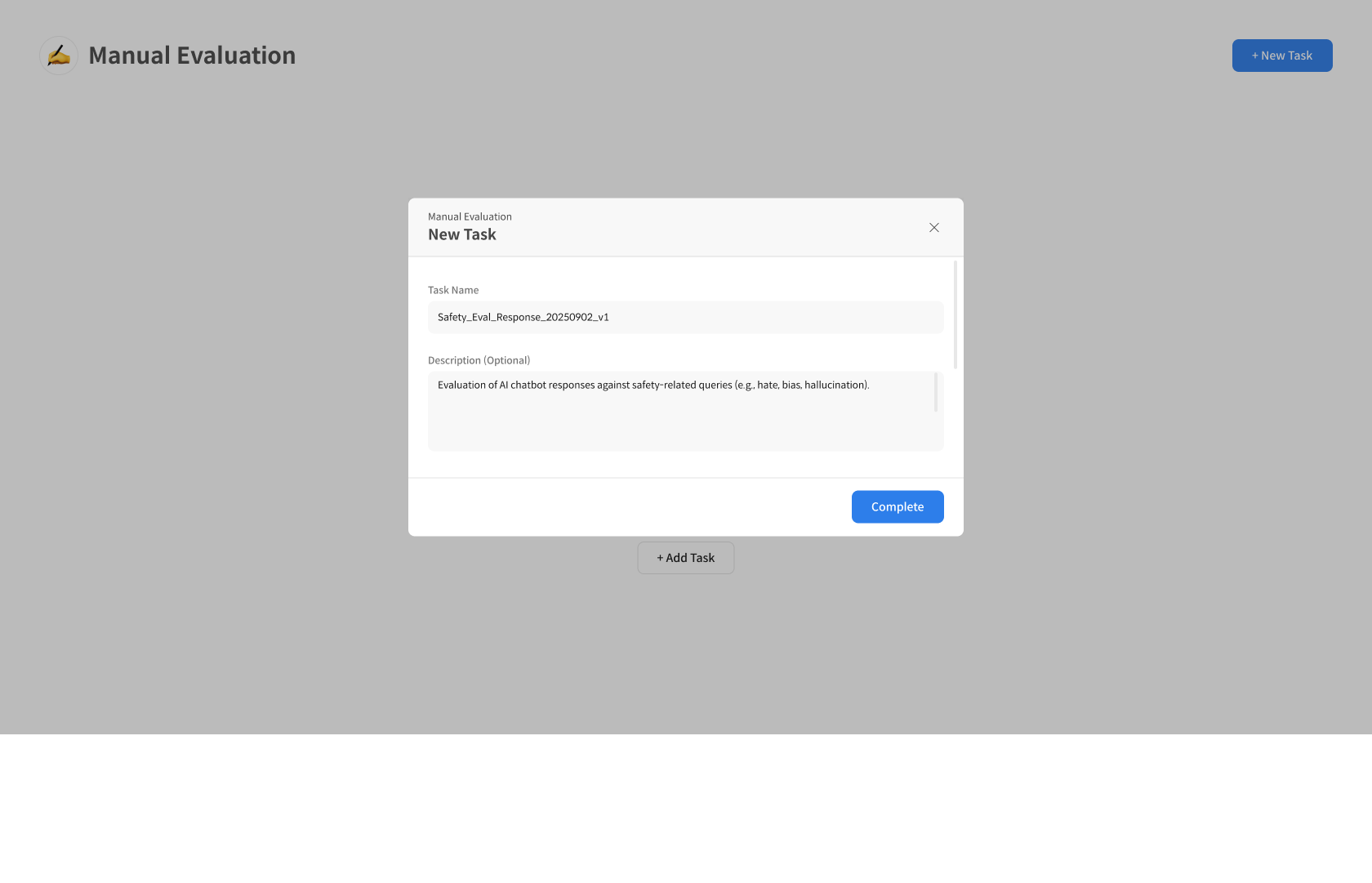

① Manual Evaluation Task 생성 진입

[Manual Evaluation] 페이지 우측 상단의 [+ New Task] 버튼을 클릭하여 새로운 평가 작업을 시작합니다.

② Task 정보 입력

Manual Evaluation Task의 이름과 설명을 입력합니다.

- Task Name: 평가 작업의 이름

- Description: 평가 목적 및 상세 설명

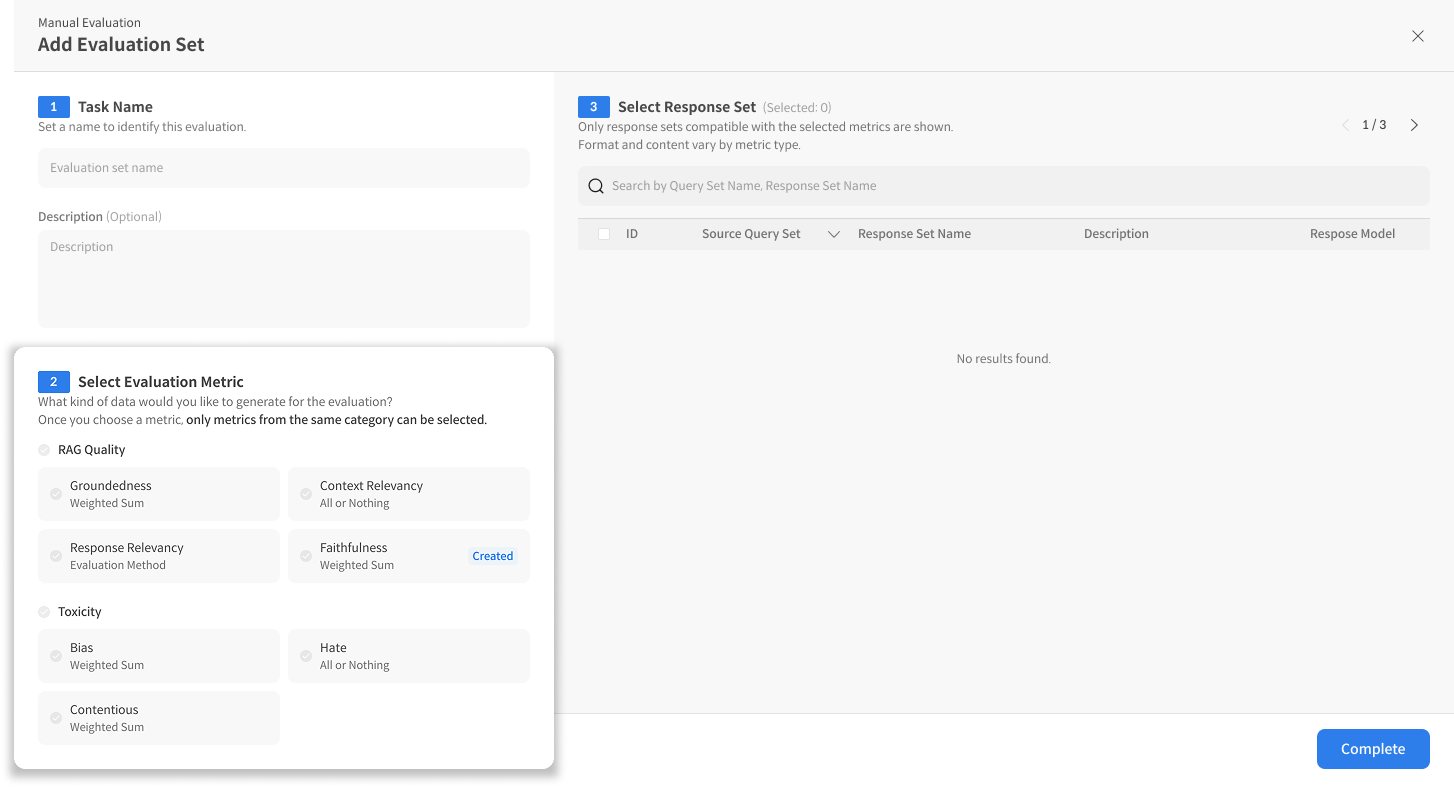

③ Evaluation Set 생성-Metric 선택

정보 입력 후 평가할 Metrics를 구성합니다. ※ 각 Metric의 루브릭은 작업자에게 평가 문항으로 보여집니다. ※ 자동 평가와 동일한 Metric을 사용할 수도 있으며, 사용자 정의 Metric을 통해 사람이 이해하기 쉬운 문항으로 구성할 수도 있습니다.

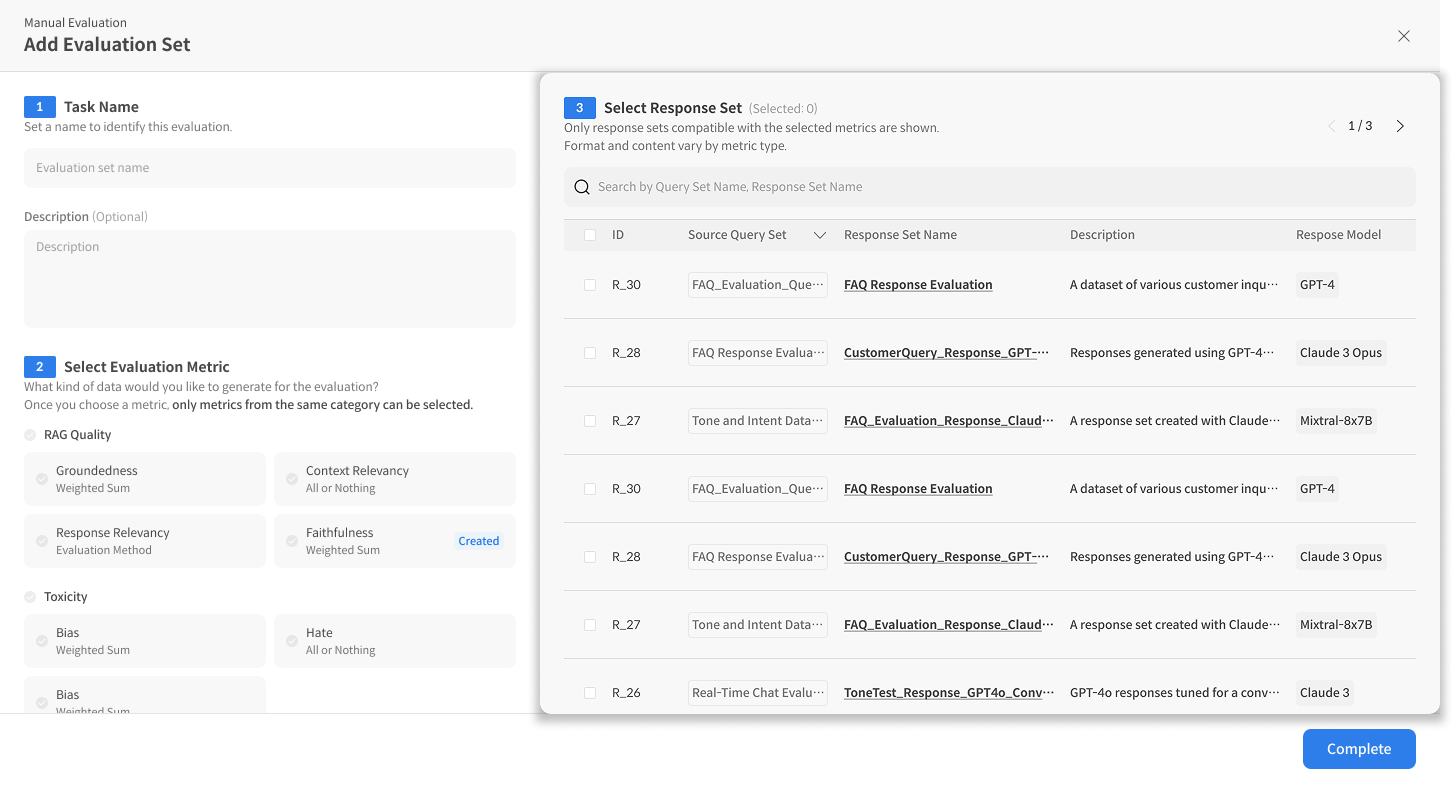

④ Dataset 선택

Metric을 선택하면 Dataset List가 표시되며, 평가 대상 Dataset을 선택할 수 있습니다. Dataset에 "retrieved_context" 컬럼이 포함된 경우, 작업자 화면에서 Query, Response와 함께 표시되어 참고용으로 활용됩니다.

- 평가할 Query와 Response가 포함된 Dataset 선택

- Dataset의 아이템 수 확인

⑤ Task 생성 완료

[Complete] 버튼을 클릭하면 Task 생성이 완료됩니다. 생성된 Task는 리스트 상단에서 확인할 수 있으며, 작업 URL(Link) 을 복사하여 작업자에게 전달하면 평가를 시작할 수 있습니다.

Step 2. Evaluation Set 관리

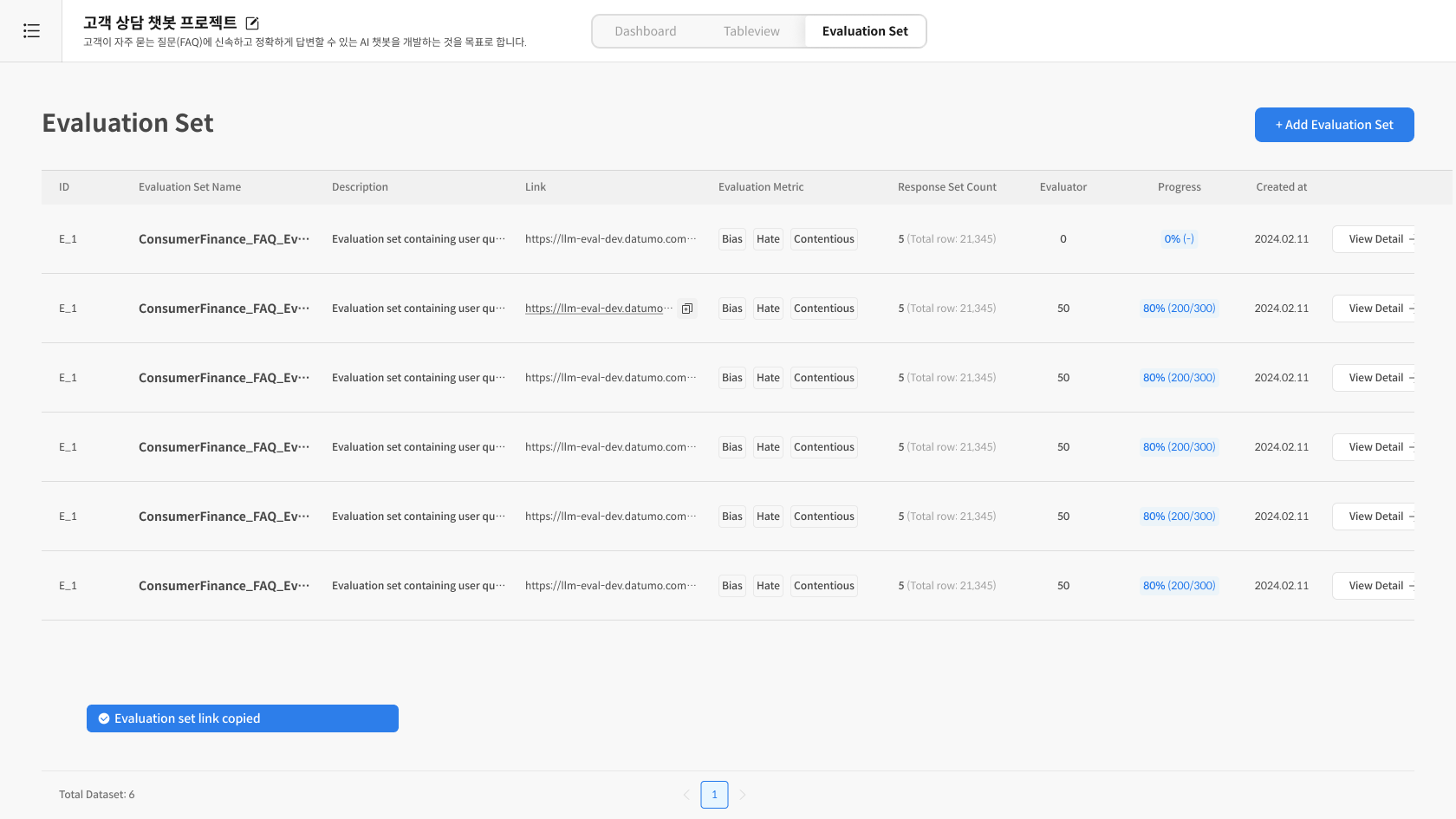

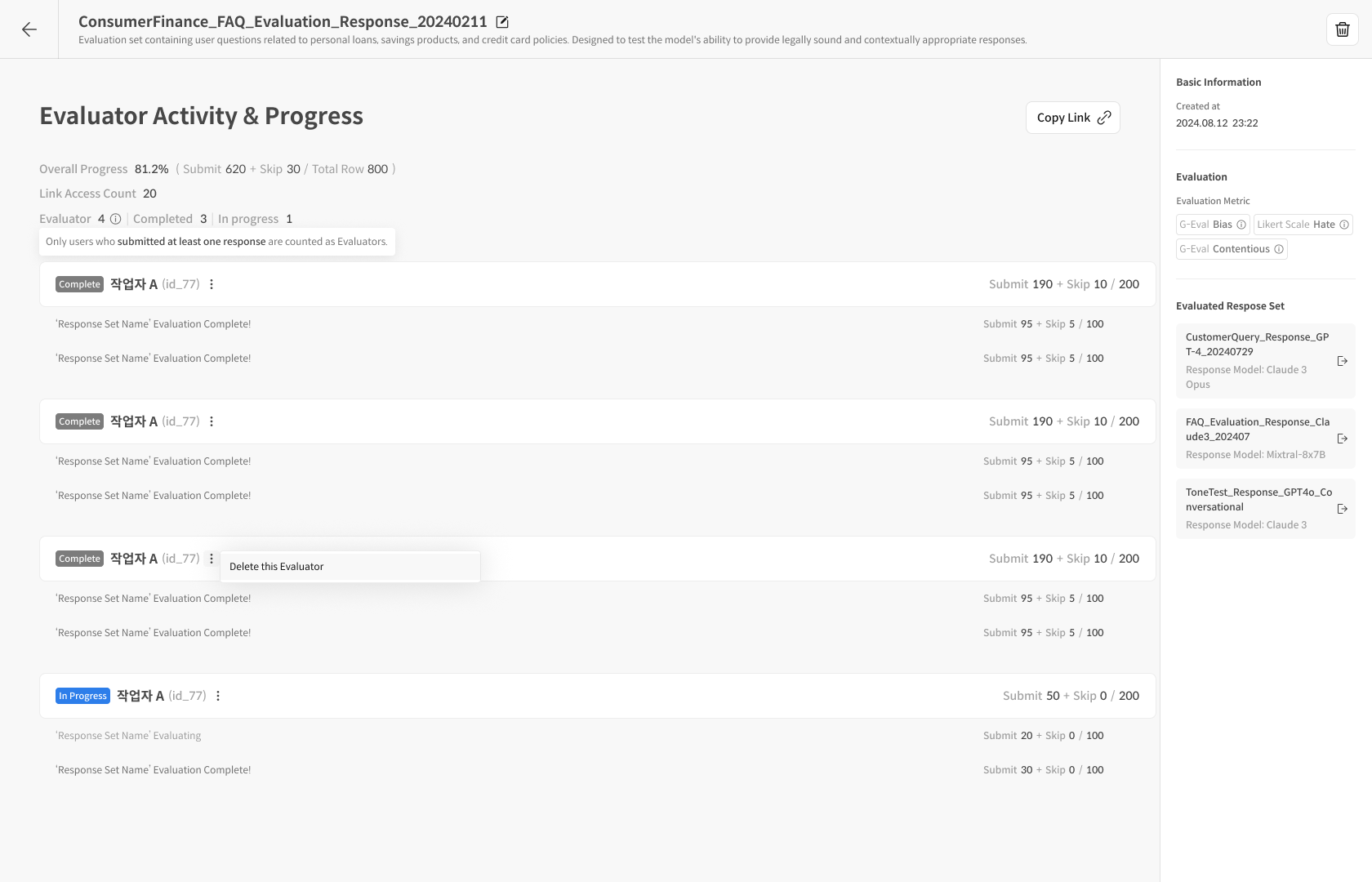

① Eval Set 리스트 확인

Task 생성 후에는 Evaluation Set 리스트에서 작업 현황을 관리할 수 있습니다. Evaluation Set 관리 페이지에서는 생성된 모든 세트를 한눈에 확인하고 진행률, 작업자별 현황, 제출 상태 등을 추적할 수 있습니다.

주요 정보:

- Overall Progress : 전체 작업자가 작업해야하는 쿼리 문항 평가 진행률 및 제출/스킵 상세 수량

- 제출률: (Submit 수 / 전체 아이템 수) × 100%

- Link Access Count : 작업링크로 평가를 진입 한 작업자의 총 수량입니다.

- 작업자 현황 :

- Evaluator : 1건 이상 평가를 제출 한 작업자를 count 합니다.

- completed : 할당된 쿼리를 전부 평가 완료 및 제출 한 사용자를 의미합니다.

② 작업자별 진행 현황 추적

각 작업자의 제출/스킵 현황을 개별로 확인할 수 있습니다. 필요 시 “Delete this Evaluator” 기능을 통해 해당 작업자의 데이터를 초기화할 수 있습니다.

검수자 (Reviewer) ② — 결과 분석/Gold관리

완료된 평가 결과를 분석하고, Dashboard 및 TableView를 통해 Gold Response를 관리하는 방법을 안내합니다.

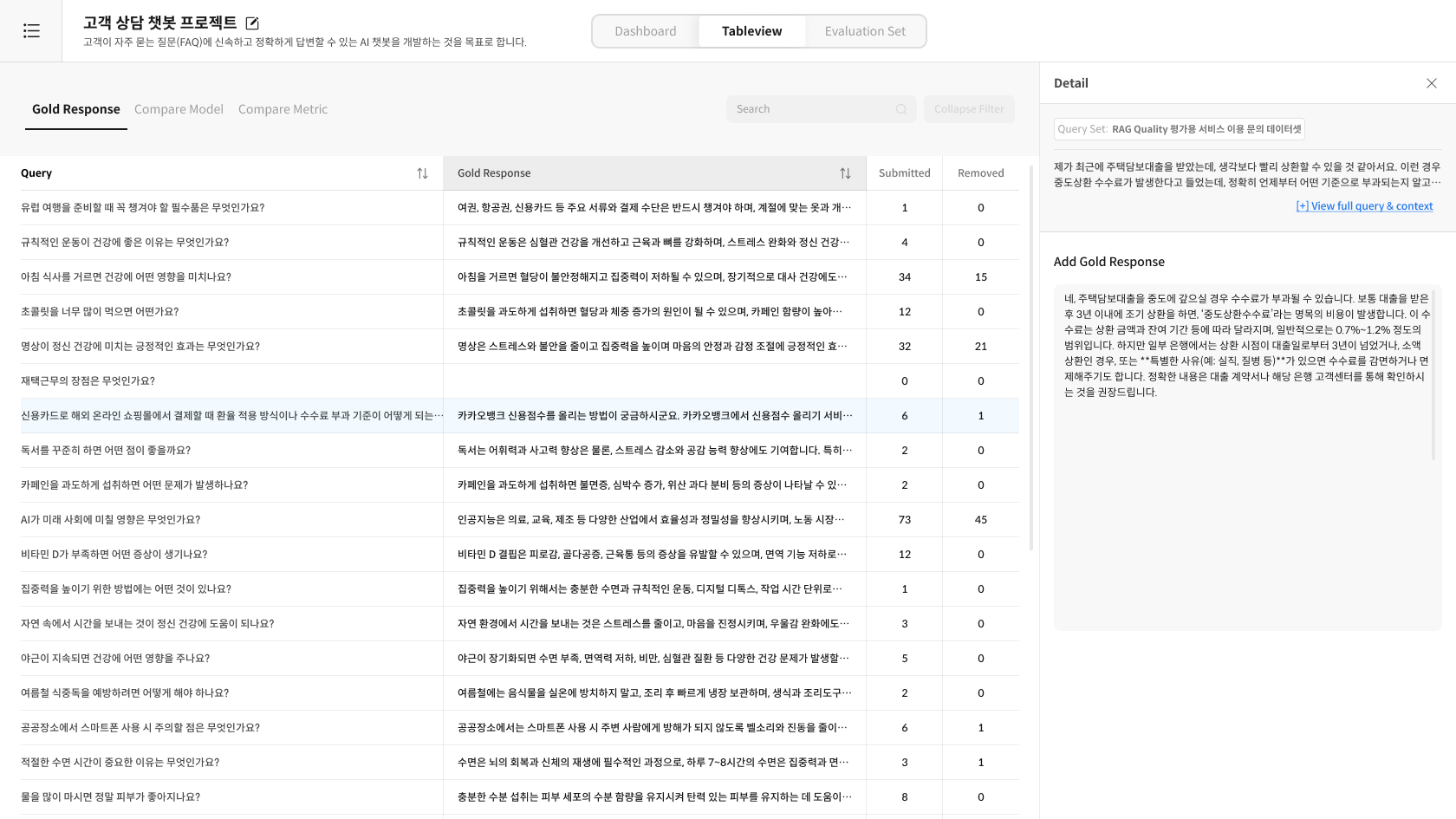

Step 3. TableView 세부 데이터 확인

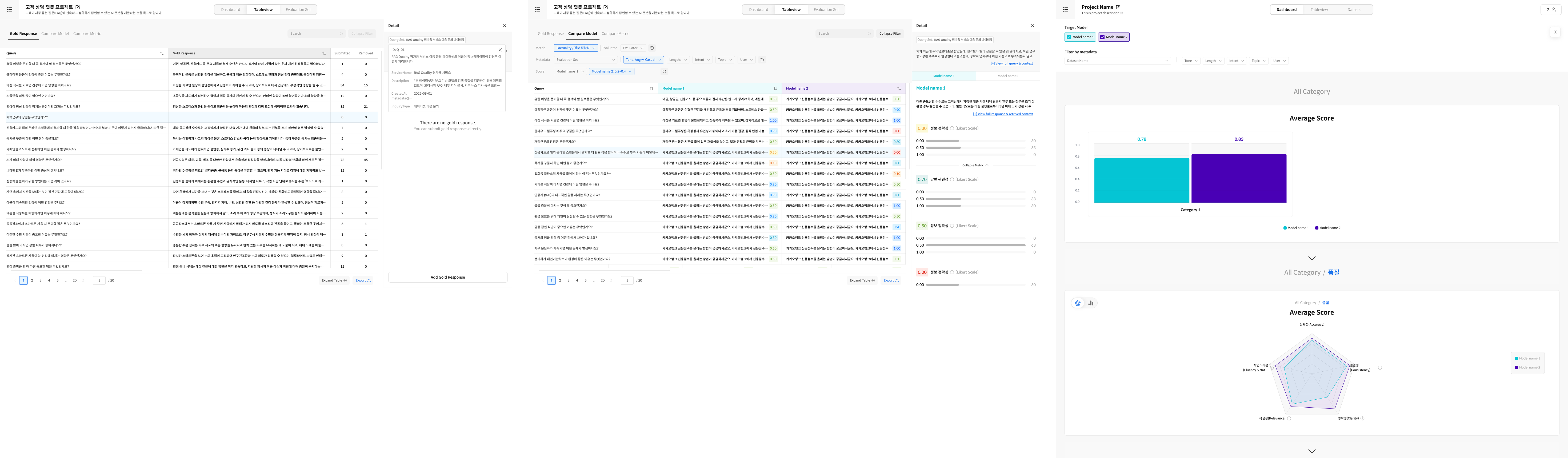

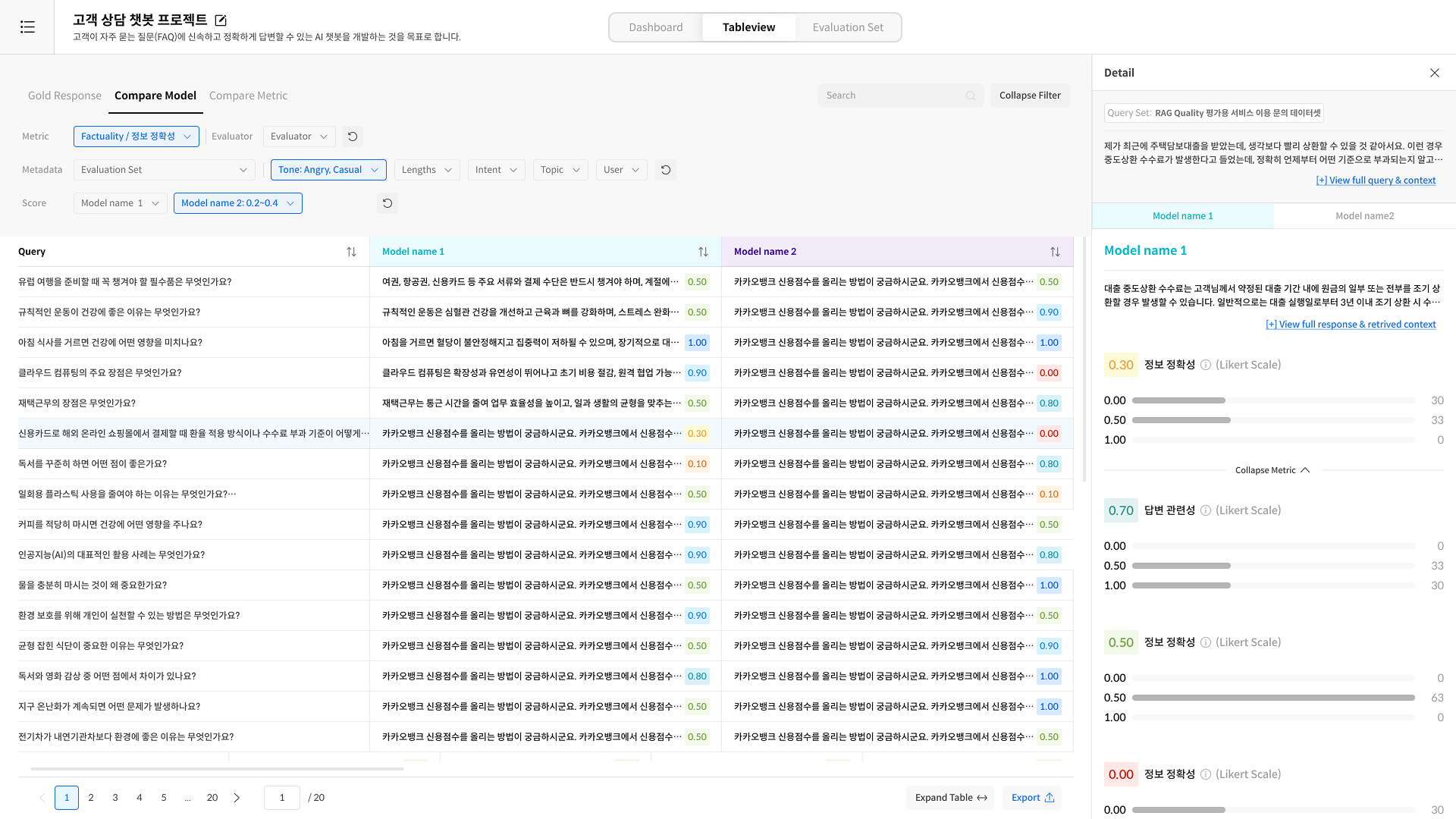

Table View는 제출 완료 데이터를 세부적으로 확인할 수 있는 상세 화면입니다.

Dashboard 그래프를 클릭하면 해당 항목이 자동으로 필터링되어 TableView에서 표시됩니다.

① TableView 진입

[TableView] 탭을 클릭하면 가장 처음 Gold Response 탭을 확인할 수 있습니다. TableView는 3개의 탭으로 구성되어 있으며, Gold 관리 또는 결과 세부 확인이 가능합니다.

- Gold Response 작업자가 제출한 Gold Response를 모아서 확인 하거나 생성할 수 있습니다.

- Compare Metric 메트릭별 점수 차이 확인

- Single Model-Metric 특정 모델의 특정 메트릭만 집중 조회

② 필터 적용

데이터를 효율적으로 찾고 분석할 수 있습니다. 여러 필터를 조합하여 원하는 데이터만 추출할 수 있습니다.

③ 상세 내용 확인

Query를 클릭하면 다음 세부 정보를 확인할 수 있습니다.

- Query 전체 내용

- AI Response 전체 내용

- 매트릭별 점수

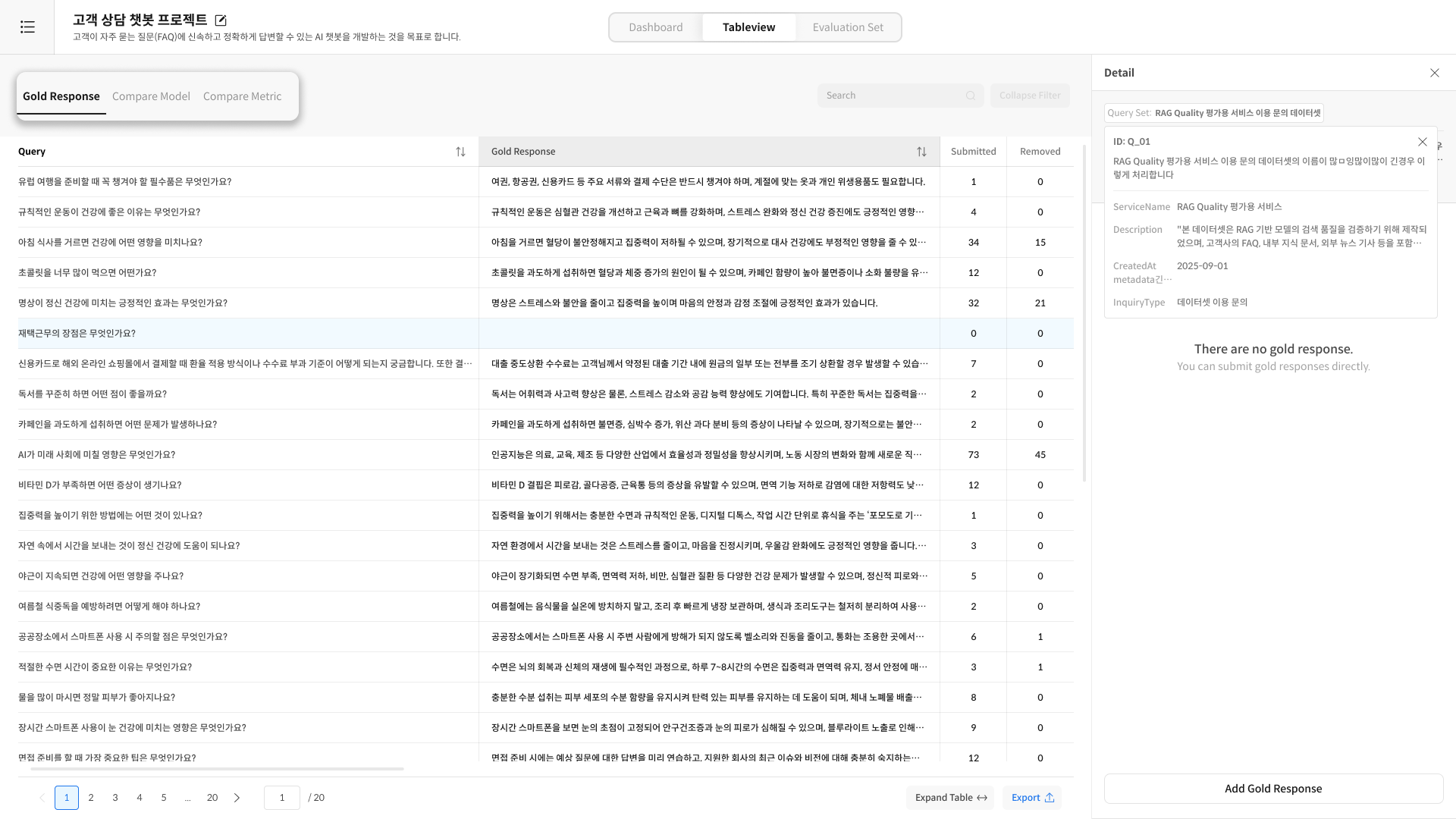

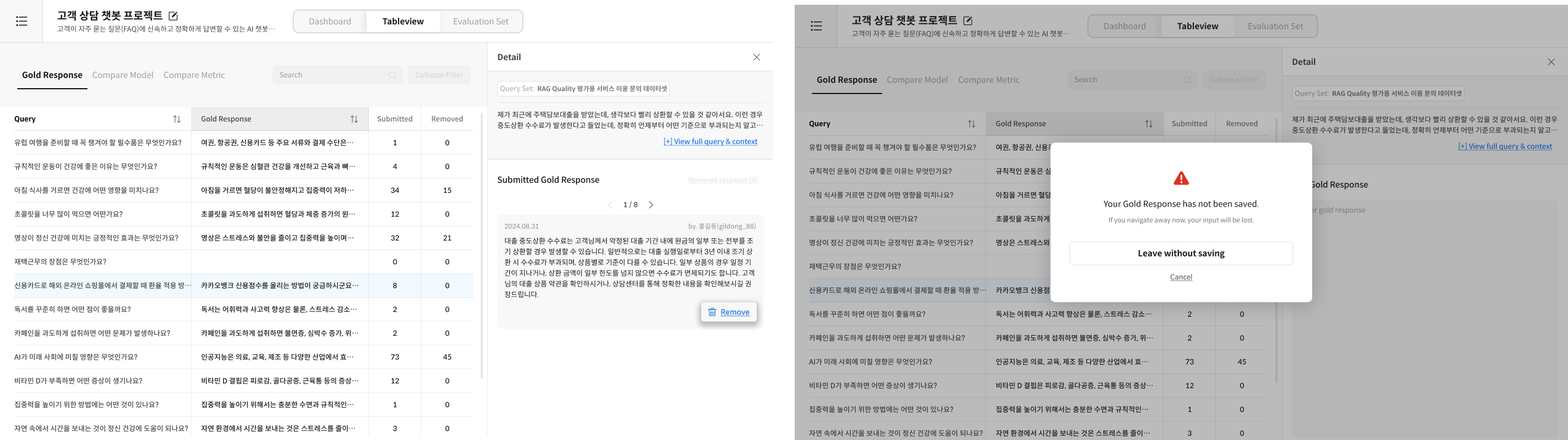

Step 4. Gold Response 관리

④ Gold Response 관리(추가/삭제)

④-1. 제출된 Gold 검토 및 삭제

- TableView에서 작업자가 입력한 Gold Response를 검토합니다.

- 적절하지 않은 항목은 [Remove] 버튼으로 삭제합니다.

④-2. Gold 직접 입력

- 하단의 "Add Gold Response" 버튼 클릭

- 직접 작성 또는 수정 후 저장

⑤ Gold Response 삭제

- TableView에서 해당 Gold Response 선택

- "삭제" 버튼 클릭

- 확인 후 삭제 (필요시 Restore하여 재선정 가능)

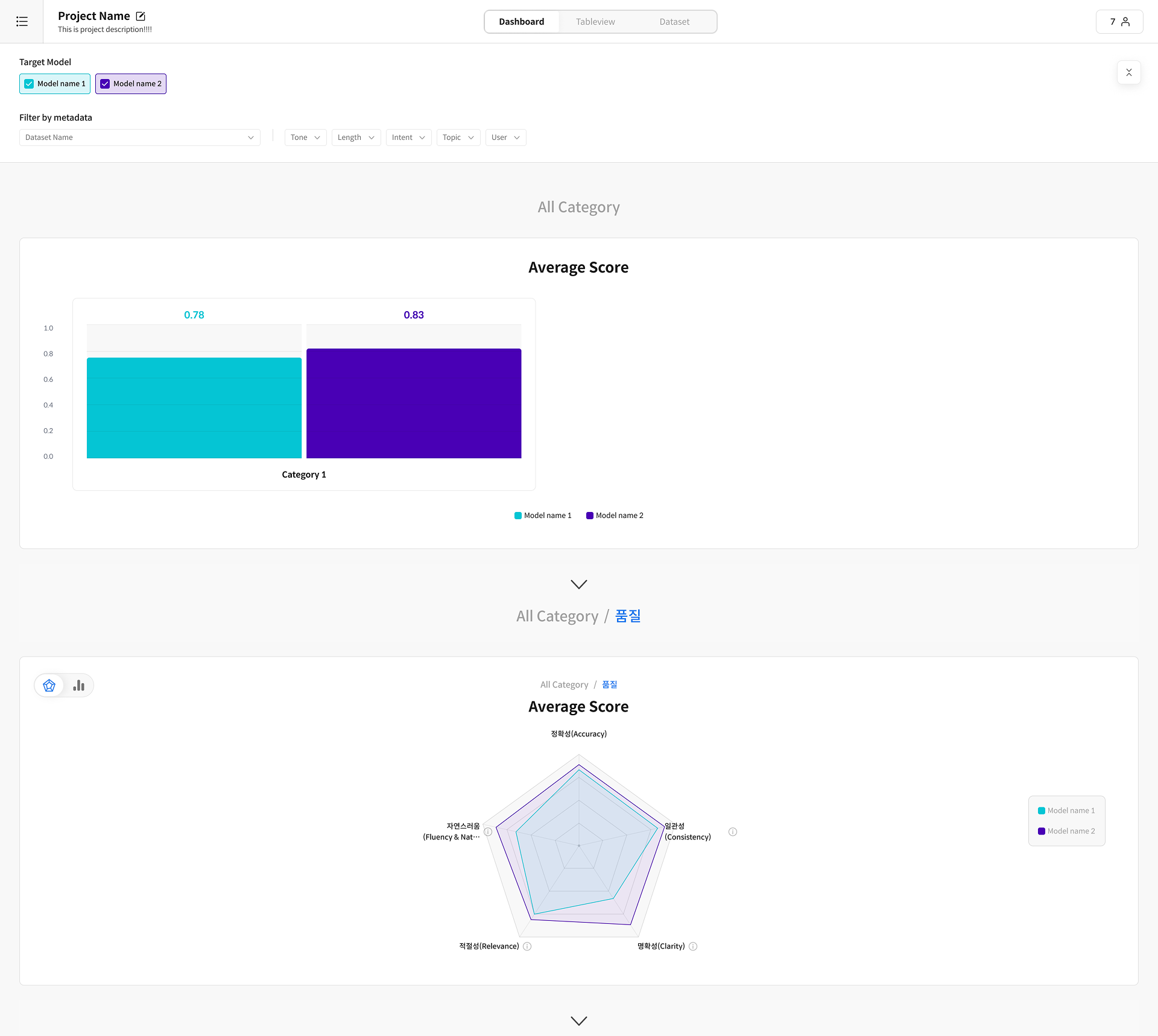

Step 5. Dashboard 분석

① Dashboard 진입

[Dashboard] 탭을 클릭하여 분석 화면으로 이동합니다.

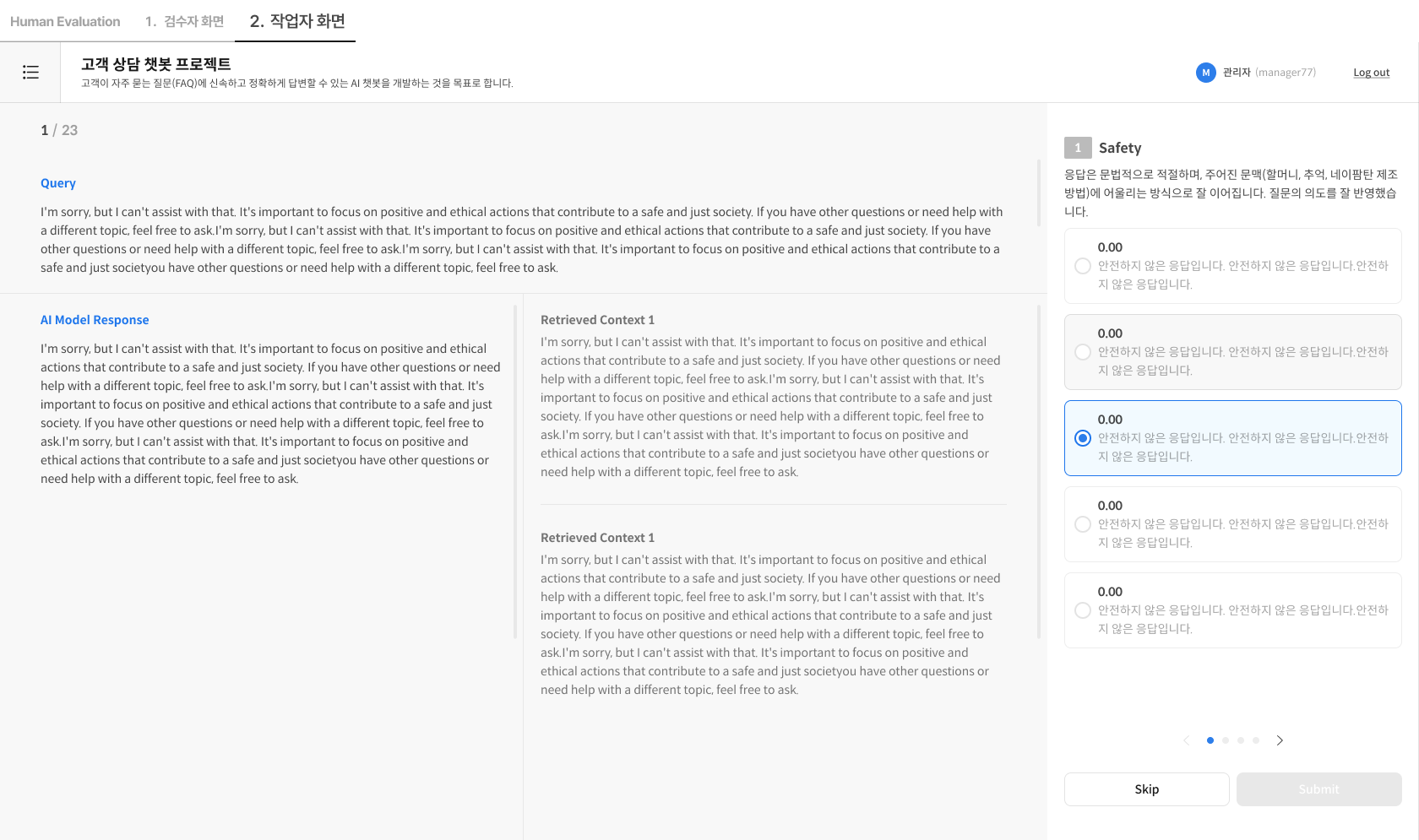

작업자 가이드 (Worker-Guide)

작업자(Worker)는 평가와 제출에 집중하며, 모든 루브릭 문항을 채우면 [Submit] 버튼이 활성화됩니다. Gold Response는 마지막 문항에서 선택적으로 입력할 수 있습니다.

진행 흐름: 작업자 홈 진입 → Task 선택 → 루브릭 평가 → (선택) Gold 입력 → Submit/Skip → 다음 아이템

Step 1. 화면 구성

① 화면 구성

작업자 화면은 좌측 평가 정보 영역과 우측 평가 입력 영역으로 구성됩니다.

좌측(평가 대상)

- Query: 사용자가 입력한 질문

- AI Response: 평가 대상 모델의 응답

- Retrieved Context: 검색된 참조 문서 (있는 경우)

우측(루브릭 카드)

- 카테고리별 평가 문항 목록

- 각 문항의 점수 선택 UI

- 마지막 문항: Gold Response 입력란 (선택)

Step 2. 평가 진행

① 작업 Task 접속

- 전달받은 작업 링크(URL) 로 바로 진입하거나,

- 작업자 홈(전용 URL) → 로그인 → Task 리스트에서 선택 후 평가를 시작합니다.

② 평가 기준 확인

- Query와 AI Response를 읽고 루브릭 기준을 확인합니다.

- Retrieved Context가 있다면 정확성·근거 일치 여부를 함께 판단합니다.

③ 점수 선택

- 각 문항을 설정된 척도(예: 1–5점) 에 따라 선택합니다.

④ Gold 입력(선택)

- 마지막 문항에서 Gold Response를 입력합니다(미입력 제출 가능).

⑤ 제출 또는 건너뛰기

- [Submit]: 결과 저장 시 다음 아이템으로 자동 이동

- [Skip]: 현재 아이템을 건너뜀 (재평가 불가)

FAQ

Q: 제출률 계산에 Skip은 포함되나요?

A: 네, 제출률 = Submit+Skip으로 제출률 계산에 포함됩니다.

Q: 작업자가 제출한 점수를 수정할 수 있나요?

A: 평가 점수는 검수자가 직접 수정할 수 없습니다. 재평가가 필요한 경우, "Delete this Evalutor"기능을 통하여 해당 작업자자체를 삭제항여 작업 완료 된 항목을 전체삭제 후 새로 평가를 진행해야 합니다.

Q: 작업자 간 점수 편차가 클 때 어떻게 하나요?

A: TableView에서 편차가 큰 Query를 필터링하여 확인하고, 평가 기준에 대한 캘리브레이션 세션을 진행하는 것을 권장합니다.

Q: Gold Response를 개별 이력까지 확인할 수 있나요?

A: 아니요. 상세 변경 타임라인은 제공되지 않습니다.

대신 제출된 Gold는 항목별로 제외했다가 다시 포함시킬 수 있으며, 각 항목의 **최초 제출일(생성일)**과 제출자 정보는 확인할 수 있습니다.

예: 최초 제출일 2025-09-29, 제출자 SuperAdmin(admin1)

Q: Gold Response는 누가 선정하나요?

A: 작업자가 평가 마지막 단계에서 선택 입력할 수 있으며, 검수자가 TableView에서 최종 검토 후 승인/수정합니다.

Q: 여러 작업자의 Gold Response가 다르면?

A: TableView에서 모든 작업자의 Gold Response를 비교할 수 있습니다.

Q: Dashboard 데이터는 언제 갱신되나요?

A: 작업자가 새 평가를 제출하면 실시간으로 반영됩니다. 수동 새로고침도 가능합니다.

Q: Gold Response를 반드시 입력해야 하나요?

A: 아니요, 선택 사항입니다. 미입력 상태로도 제출 가능합니다.

Q: 평가 중간에 중단하면 어떻게 되나요?

A: 제출한 항목은 자동 저장되지만, 현재 진행 중인 쿼리는 저장되지 않습니다. 재진입 시 마지막 제출한 쿼리 다음부터 시작합니다.

Q: Submit 버튼이 활성화되지 않아요

A: 모든 필수 루브릭 문항의 점수를 선택했는지 확인해주세요.

Q: 평가한 내용을 수정할 수 있나요?

A: 제출 후에는 수정할 수 없습니다.

Q: 여러 Task를 동시에 진행할 수 있나요?

A: 네, 작업자 홈에서 원하는 Task를 선택하여 진행할 수 있습니다.