RAG Checker를 어떻게 실행하나요?

✅ RAG Checker Overview

RAG Checker는 Expected Response(ER) 와 Target Response(TR) 를 비교하여

RAG 시스템의 정확도(Factuality) 및 검색·생성 단계별 성능을 자동으로 평가하는 도구입니다.

데이터셋을 업로드하고 평가 Task를 생성하면,

Precision, Recall, Faithfulness, Hallucination 등 주요 지표를 자동 산출해

모델의 사실 충실도와 정보 활용도를 정량적으로 확인할 수 있습니다.

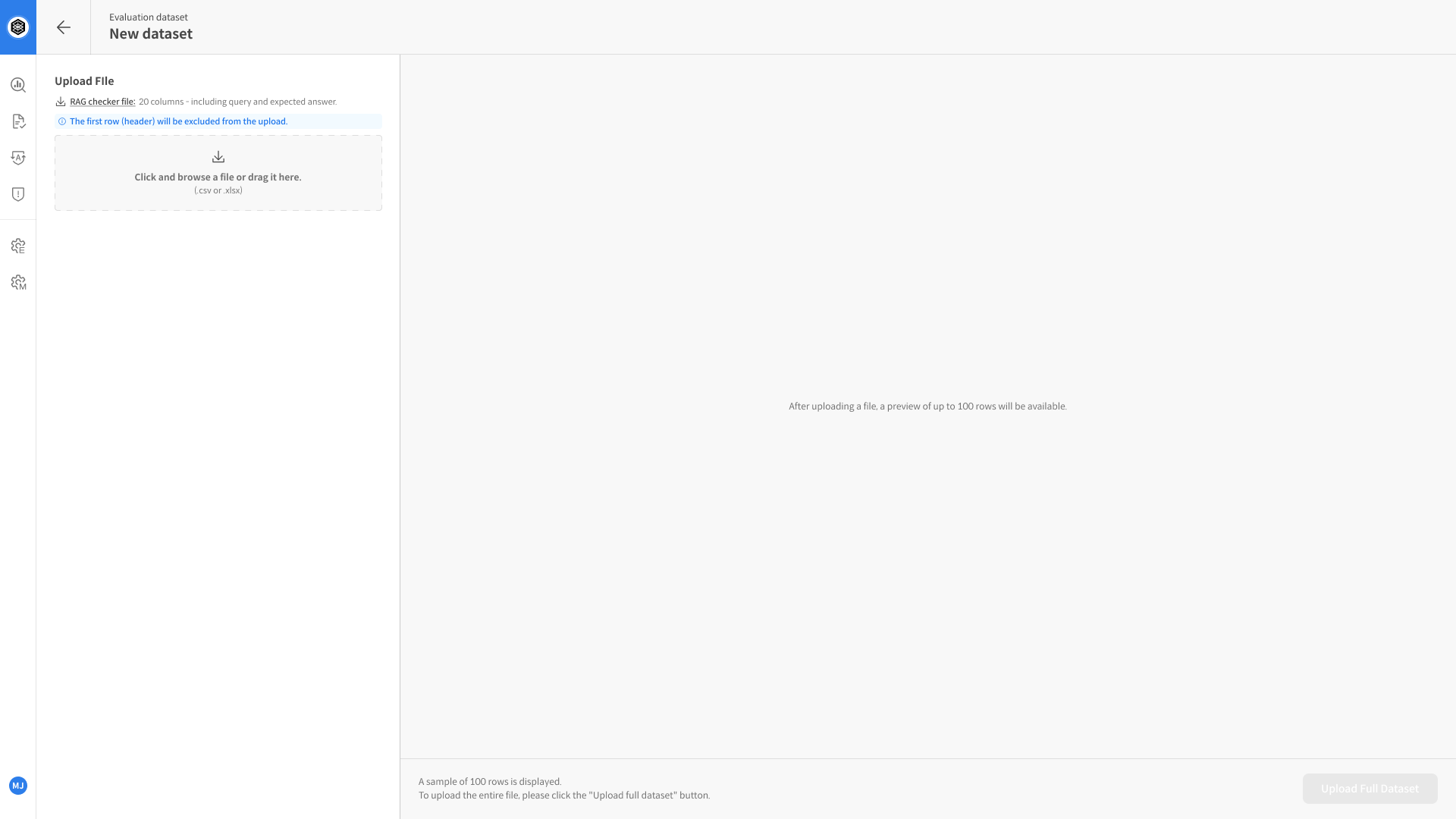

Step 1. 데이터셋 준비하기

평가를 수행하기 전에, 아래 항목을 포함한 데이터셋을 준비합니다.

📂 데이터셋 업로드 가이드 확인하기

| 컬럼명 | 설명 |

|---|---|

query | 사용자의 입력 질문 |

expected_response | 해당 질문에 대한 기대 정답(ER, Expected Response) |

response | RAG 시스템이 실제로 생성한 Target Response |

retrieved_context1 | 모델이 답변 생성 시 참조한 문서(컨텍스트) 다수의 문서를 사용할 경우 retrieved_context2, retrieved_context3 ... 형태로 순차 추가 |

- 지원 형식:

.csv,.xlsx - 필수 컬럼:

query,expected_response,response,retrieved_context1

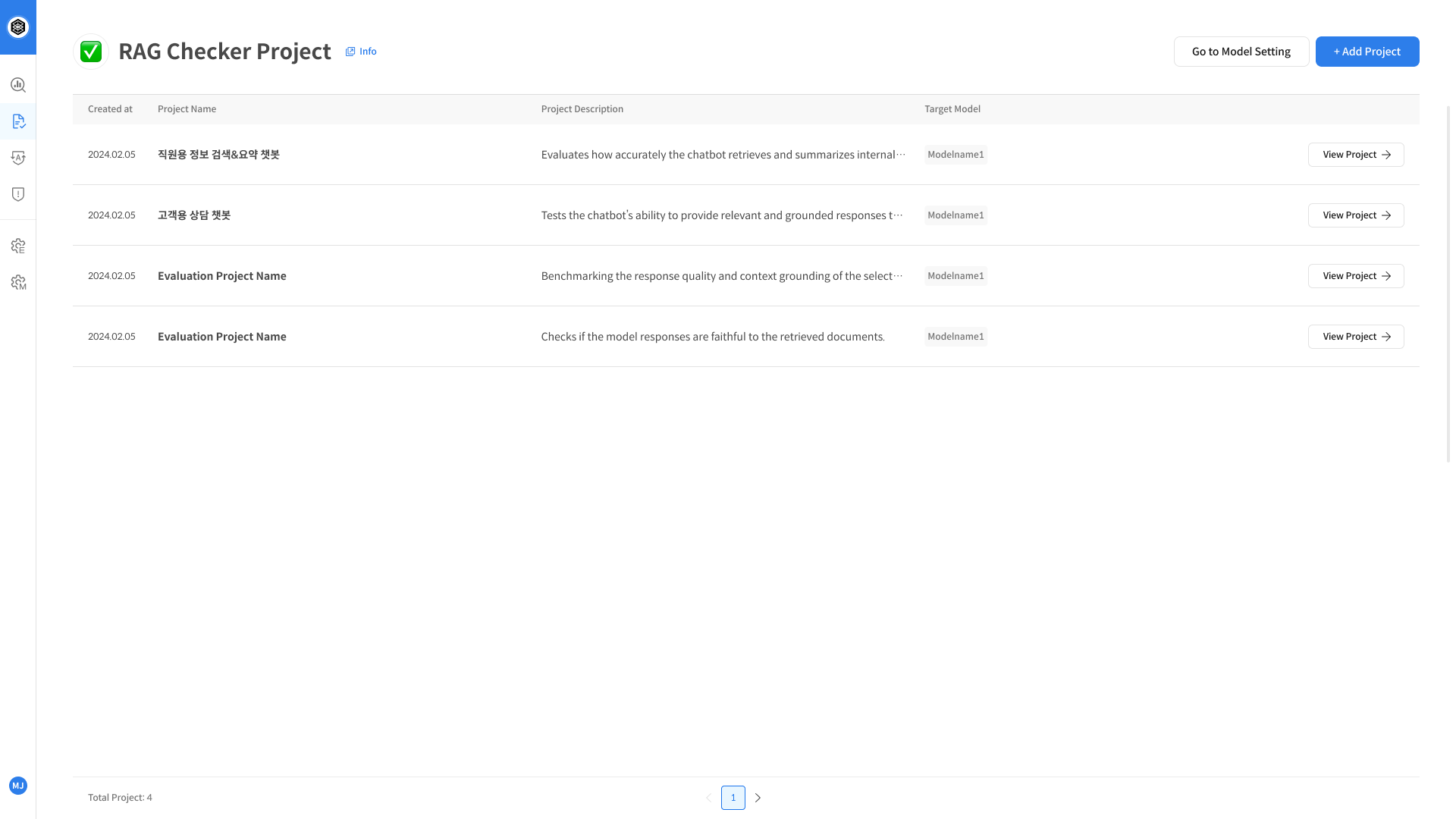

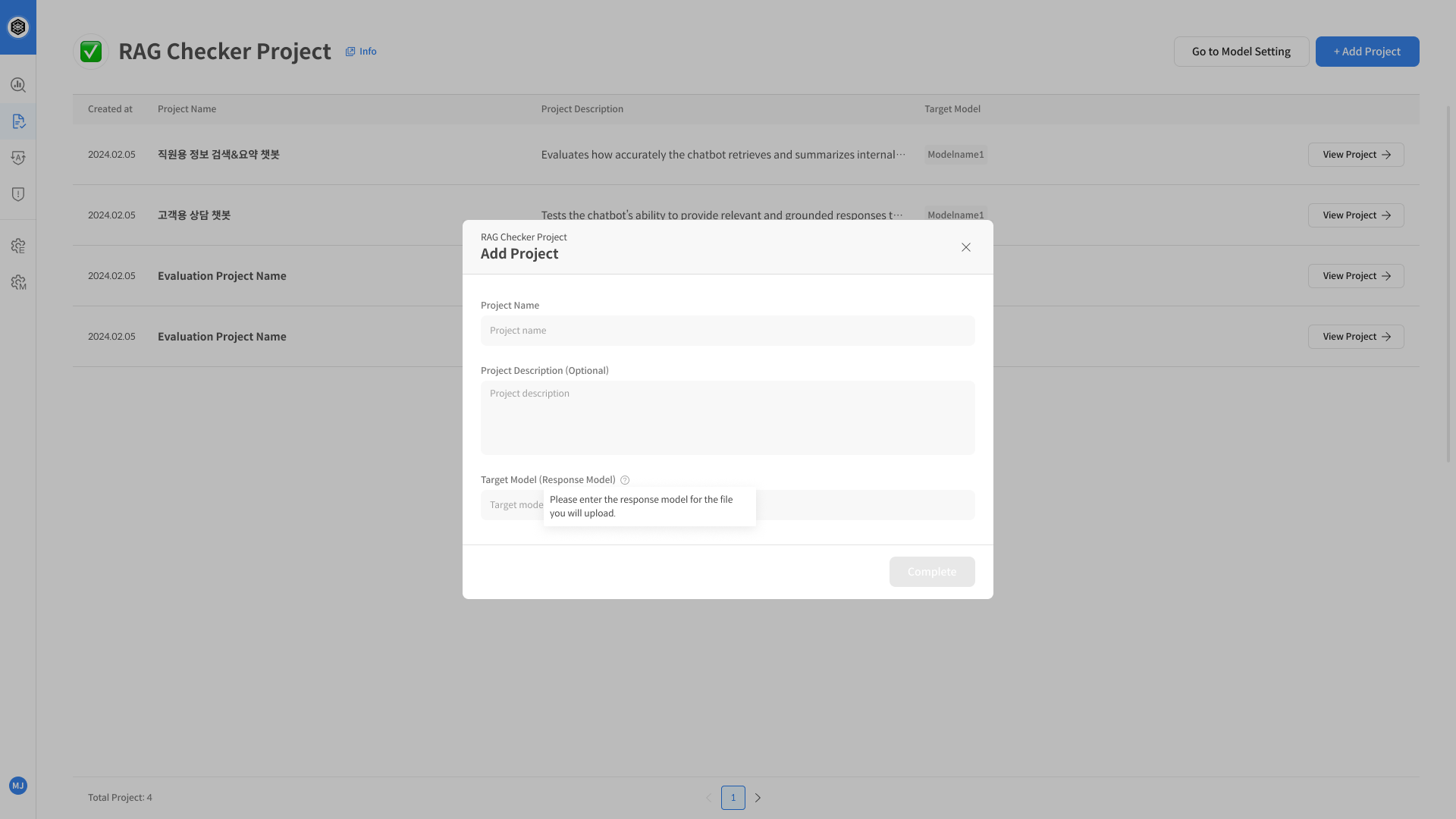

Step 2. RAG Checker Task 생성

- 좌측 네비게이션에서 RAG Checker 메뉴를 선택합니다.

- 우측 상단의 + Add Task 버튼을 클릭합니다.

- 팝업 창에서 다음 정보를 입력합니다:

- Task Name: 평가 이름

- Description: 간단한 설명

- Target Model: 평가할 RAG 시스템 또는 LLM 명칭

- 입력이 완료되면 [Create] 버튼을 눌러 Task를 생성합니다.

Task가 생성되면 Evaluation Set 생성 단계로 이동합니다.

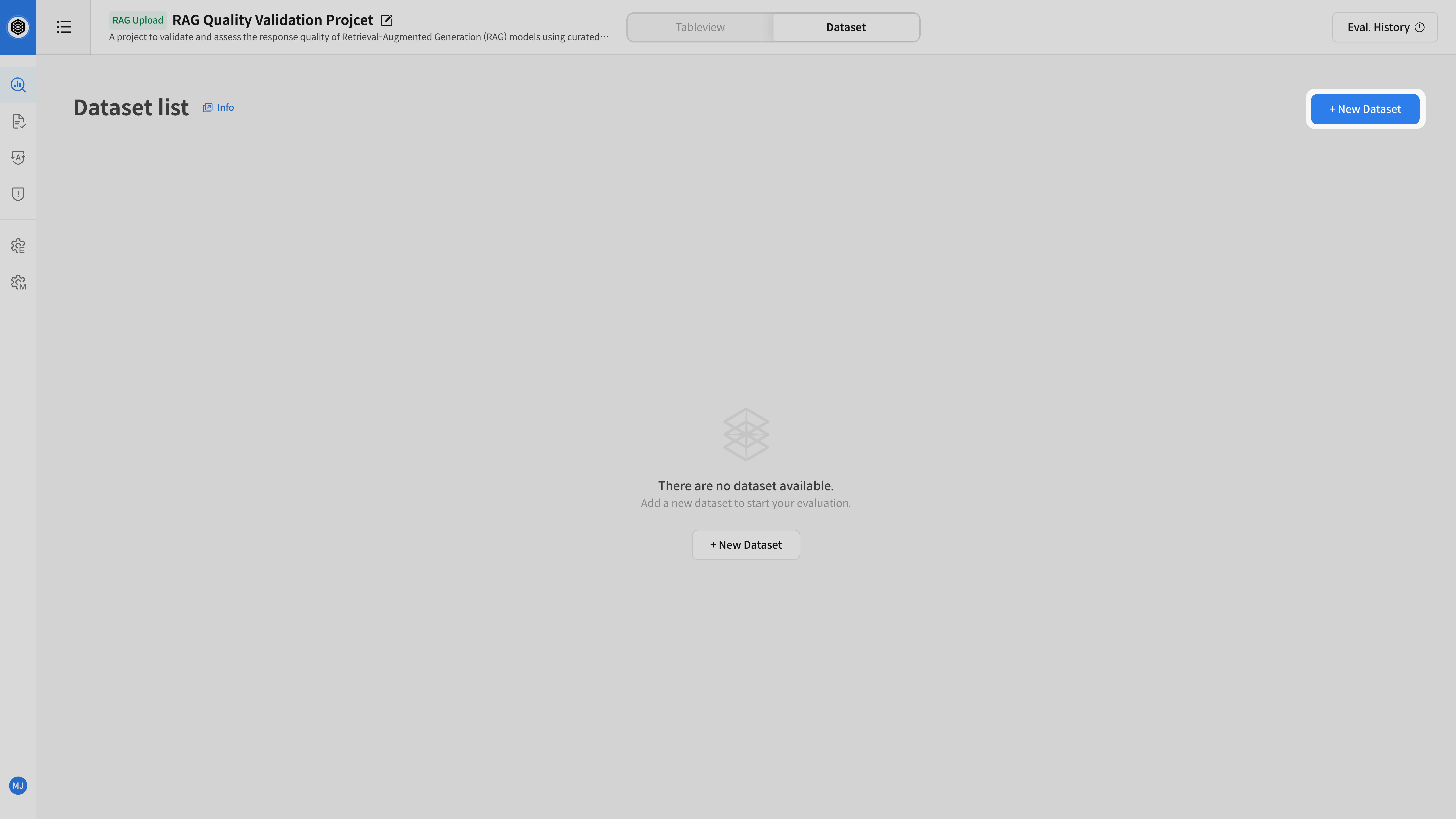

Step 3. 평가 세트 생성 및 실행

- 생성된 Task 상세 화면으로 이동합니다.

- 상단 탭에서 [Evaluation Set] 을 선택하고 + New Eval Set 버튼을 클릭합니다.

- 다음 설정을 지정합니다:

- Decomposition Model 선택 (응답을 Claim 단위로 분해)

- Entailment Model 선택 (각 Claim이 문서(Context)에 근거하는지 판별)

- Set Name / Description 입력

- 평가에 사용할 데이터셋을 선택합니다.

- [Start Evaluation] 버튼을 클릭하여 평가를 시작합니다.

평가가 시작되면, RAG Checker는 자동으로 다음 단계를 수행합니다:

- 응답을 검증 가능한 Claim 단위로 분해

- 각 Claim이 검색된 문맥(Passage)으로부터 논리적으로 수반(Entailment)되는지 판별

평가가 완료되면 다음 단계에서 결과를 확인할 수 있습니다.