BEIR Leaderboard

BEIR(📊 Benchmark for Information Retrieval) 평가는

Judge 평가와 함께 Retrieval 품질(Recall, Precision 등) 을 측정할 수 있는 표준화된 벤치마크 평가입니다.

특정 조건을 만족하는 Dataset을 선택하면

시스템이 BEIR 평가를 함께 수행할 수 있는 옵션을 제공합니다.

평가 완료 후에는 Dashboard 상단의 BEIR Leaderboard에서 결과를 확인할 수 있습니다.

RAGAs Task에서 특정 데이터 조건을 만족하는 데이터셋을 사용하면,

Judge 평가와 함께 표준화된 BEIR 벤치마크 평가가 자동으로 실행되며 평가 결과 확인 시 대시보드 상단에서 확인 할 수 있습니다.

Step 1. BEIR 평가 자동 실행 조건

BEIR 평가가 자동으로 실행되려면 Dataset에 다음 특수 컬럼들이 반드시 포함되어 있어야 합니다:

※ 참조할 청크나 문서가 여러개인 경우 엑셀 컬럼 뒤 숫자를 (1,2,...n) 붙이면 모든 컬럼을 참조합니다.

-

Query 필수 컬럼: 다음 컬럼명 중 하나가 포함되어야 합니다:

gold_chunk_n,gold_chunkn,gold_context_n,gold_contextn -

Response Set 필수 컬럼: 다음 컬럼명 중 하나가 포함되어야 합니다:

retrieved_chunk_n,retrieved_chunkn,retrieved_context_n,retrieved_contextn

Step 2. 평가 진행 흐름

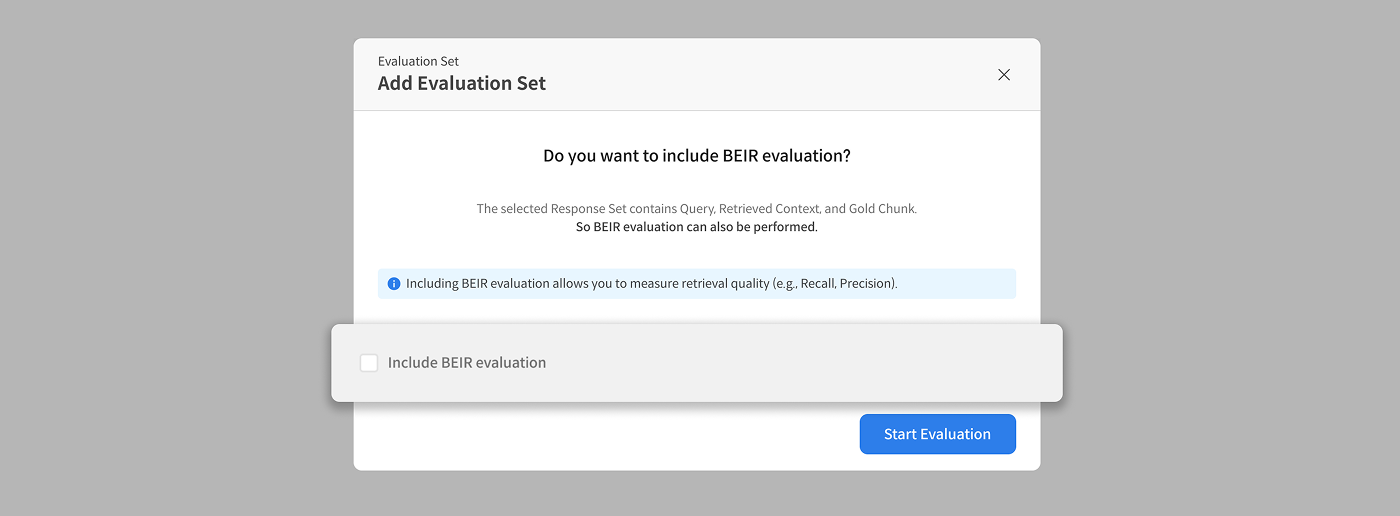

조건을 만족하는 Dataset을 선택하면, 시스템이 BEIR 평가 포함 여부를 선택하는 모달을 표시합니다.

사용자는 BEIR 평가 진행 여부를 직접 선택할 수 있습니다.

① Include BEIR evaluation 체크박스를 선택하면 BEIR 평가가 함께 수행됩니다.

BEIR 평가 포함 여부를 선택하는 모달 화면

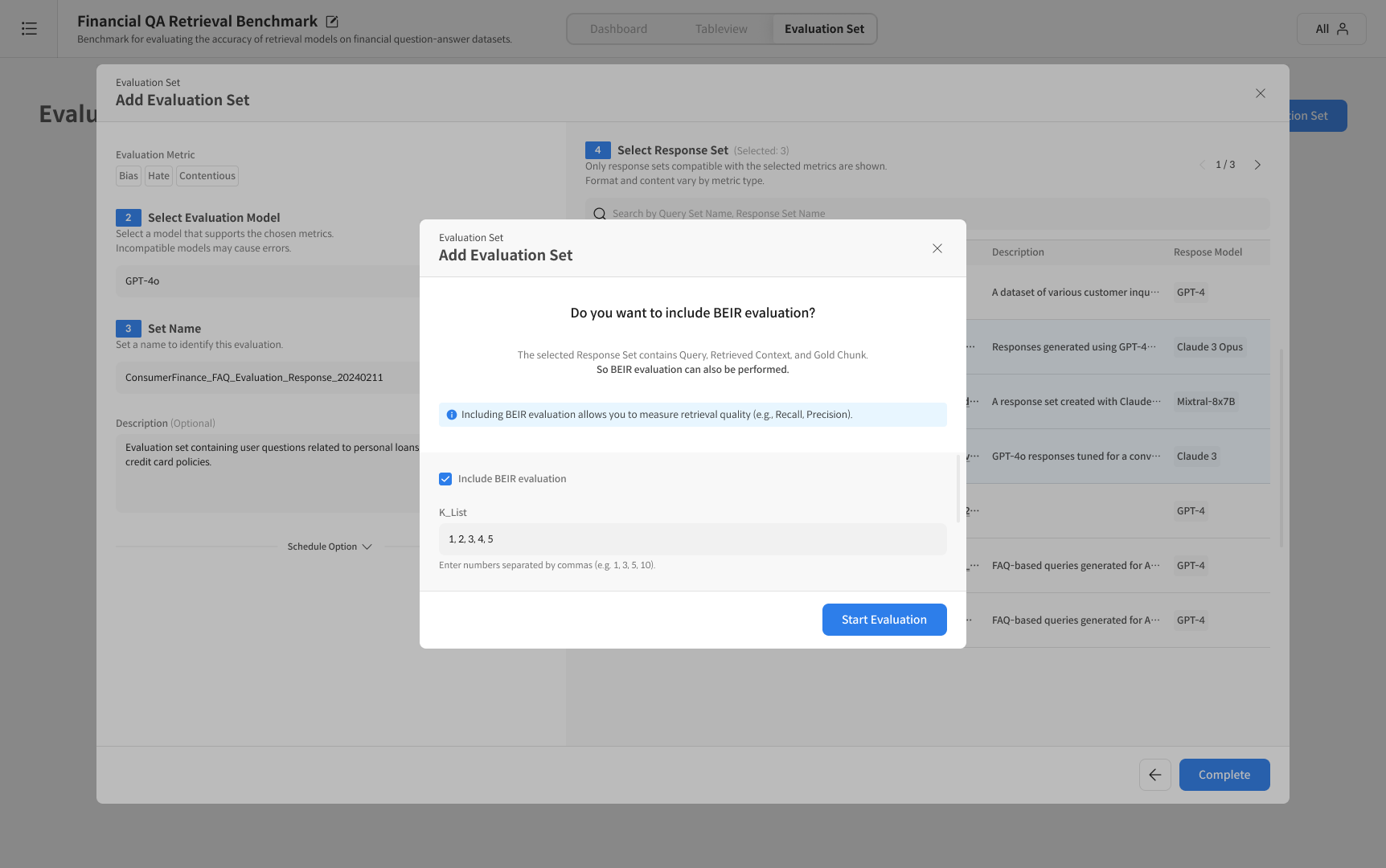

② 체크 시, K-List 입력 필드가 활성화됩니다.

- 예:

1, 2, 3, 5, 10(쉼표로 구분하여 입력)

③ Start Evaluation 클릭 시, Judge 평가 + BEIR 평가가 동시에 진행됩니다.

- 체크하지 않으면 Judge 평가만 수행됩니다.

K-List 설정 화면

BEIR 평가는 Retrieval 품질(Precision, Recall 등) 을 함께 측정합니다.

④ 결과 확인

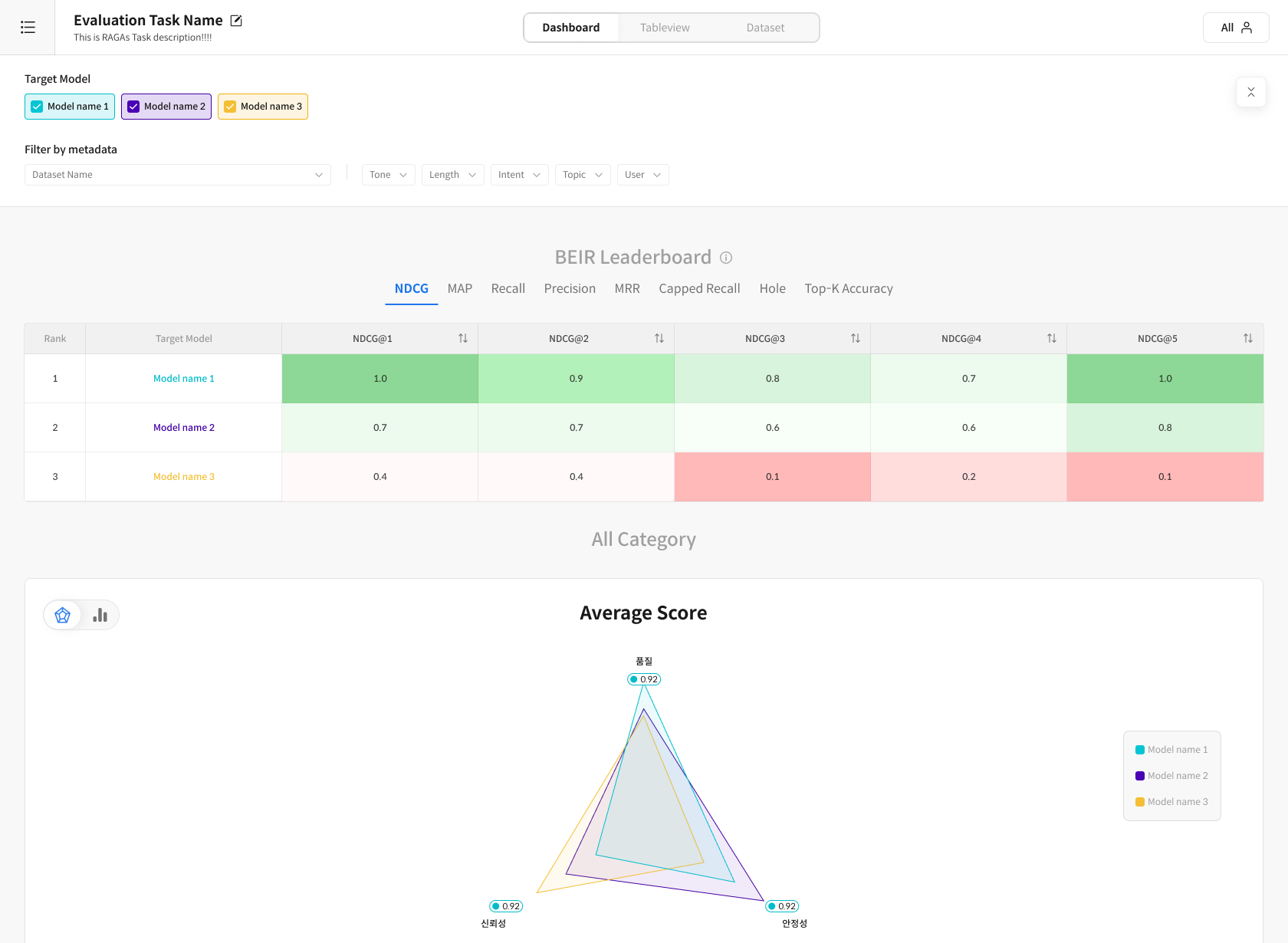

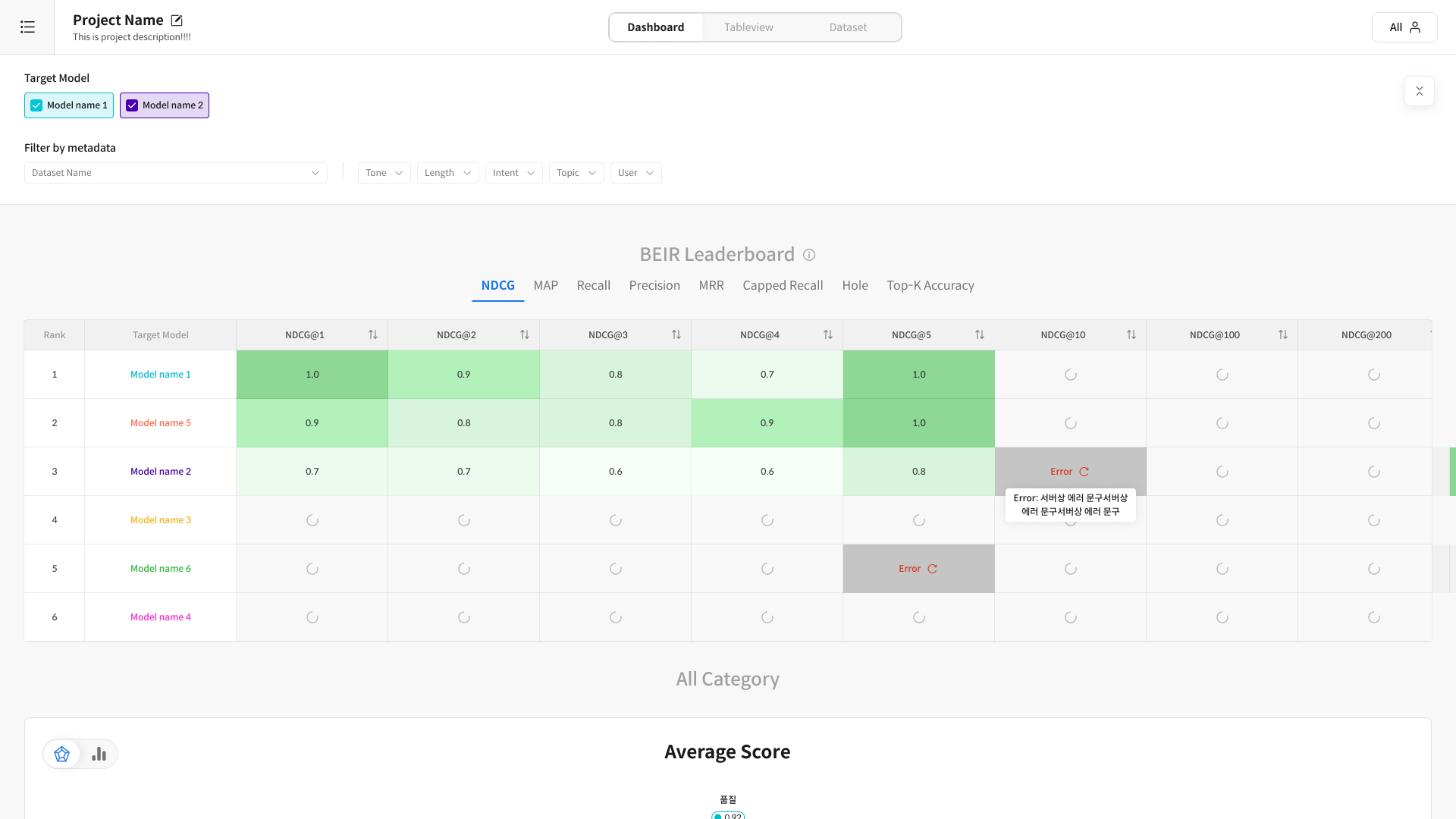

평가가 완료되면 대시보드 상단에 BEIR Leaderboard가 활성화되며,

입력한 K-List 기준으로 Precision / Recall / F1 등 주요 지표를 확인할 수 있습니다.

BEIR Leaderboard 화면 예시

❗주의사항

- BEIR 평가에는 “중지(Pause)” 기능이 없습니다.

- BEIR 평가는 Response Set 기준으로 실행됩니다.

동일한 Response Set을 선택했다면, 평가 목록에 1개의 결과만 표시됩니다. - 결과는 Judge 평가와 함께 Dashboard에서 확인할 수 있습니다.